Como otimizar o seu ficheiro Robots.txt para uma melhor SEO no WordPress

Um elemento-chave de SEO que os principiantes frequentemente ignoram é o ficheiro robots.txt. Este ficheiro aparentemente simples desempenha um papel vital na orientação dos motores de busca sobre as partes do seu sítio Web a que devem aceder, rastrear e indexar, ajudando-o a poupar valiosos recursos de rastreio e a melhorar a SEO do seu sítio WordPress.

Este guia abrangente explora porquê e como otimizar o seu ficheiro robots.txt, as melhores práticas a seguir, os erros comuns a evitar e os métodos para o criar ou editar no WordPress.

O que é um ficheiro Robots.txt e porque é que é importante para SEO?

A robots.txt é um ficheiro de texto armazenado no diretório raiz do seu Web site que indica aos motores de busca como rastrear determinadas áreas do seu site. Ao controlar o que os motores de busca podem aceder, um ficheiro bem optimizado robots.txt pode:

- Ajude os motores de busca a concentrarem-se nas suas páginas mais importantes, melhorando o desempenho de SEO.

- Evite que os motores de busca desperdicem recursos em páginas desnecessárias ou de baixo valor.

- Controle o conteúdo que aparece nos resultados de pesquisa, ajudando-o a gerir a imagem pública do seu site.

Sem um robots.txt Se não tiver um ficheiro, os motores de busca continuarão a rastrear o seu site, mas perderá a capacidade de os afastar das páginas que não contribuem para os seus objectivos de SEO.

Elementos críticos de um ficheiro Robots.txt

Um ficheiro robots.txt inclui instruções para os bots dos motores de busca, ou "agentes do utilizador", especificando que partes do seu site devem ser rastreadas ou ignoradas. Eis uma descrição simples dos componentes:

- Agente do utilizador: Especifica a que bot do motor de busca se aplica a regra (por exemplo, Googlebot para o bot do Google).

- Não autorizar: Bloqueia o acesso dos bots a URLs ou diretórios específicos.

- Permitir: Permite que os bots rastreiem URLs específicos, o que ajuda a anular as regras de não permissão.

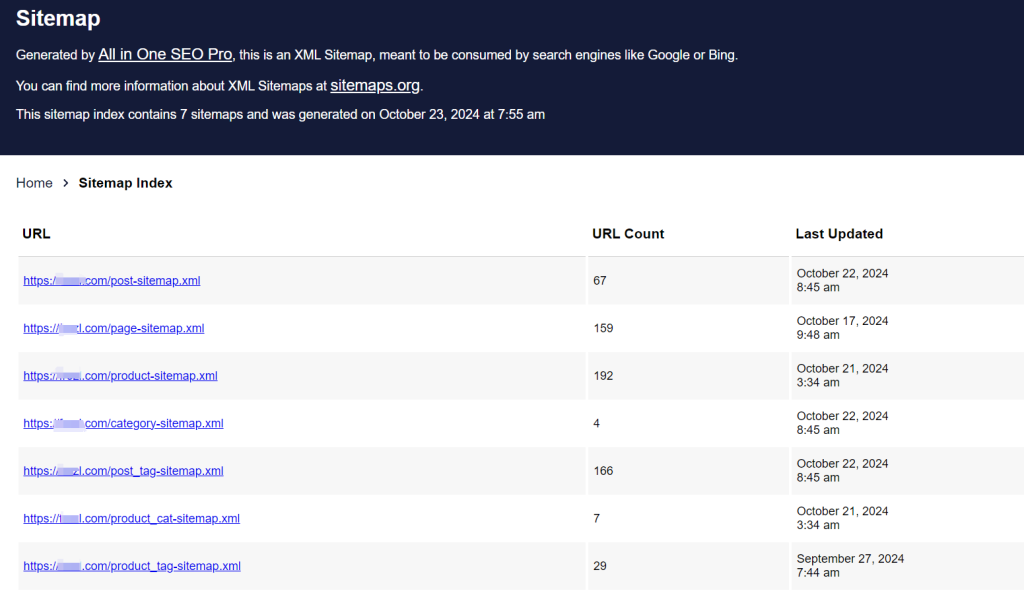

- Mapa do sítio: Indica a localização do seu mapa do site XML, que fornece aos motores de busca uma lista completa de URLs no seu site para facilitar a descoberta e a indexação.

Exemplo de estrutura de ficheiro Robots.txt

Eis a estrutura básica de um robots.txt file:

User-agent: [nome do user-agent]

Não permitir: [cadeia de URL que não deve ser rastreada]

User-agent: [nome do user-agent]

Permitir: [URL string to be crawled]

Mapa do site: [URL do seu Sitemap XML]

Por exemplo, na configuração de um site WordPress, um típico robots.txt pode ter o seguinte aspeto:

Agente do utilizador: *

Permitir: /wp-content/uploads/

Não permitir: /wp-content/plugins/

Não permitir: /wp-admin/

Mapa do site: https://example.com/sitemap_index.xmlEste exemplo permite que os bots acedam a ficheiros multimédia no /uploads/ restringe o acesso ao diretório /plugins/ e /admin/ e inclui o URL do mapa do site para que seja mais fácil para os bots encontrarem os URLs do seu site.

Porque precisa de um ficheiro Robots.txt para o seu site WordPress?

Não é necessário um ficheiro robots.txt para que os motores de busca rastreiem o seu sítio. No entanto, com um, pode ter a oportunidade de orientar os bots de forma mais eficaz. Para sítios mais significativos ou sítios com estruturas complexas, um ficheiro robots.txt é essencial para poupar recursos de rastreio, dar prioridade a páginas de elevado valor e garantir que os motores de busca não acedem a conteúdos desnecessários.

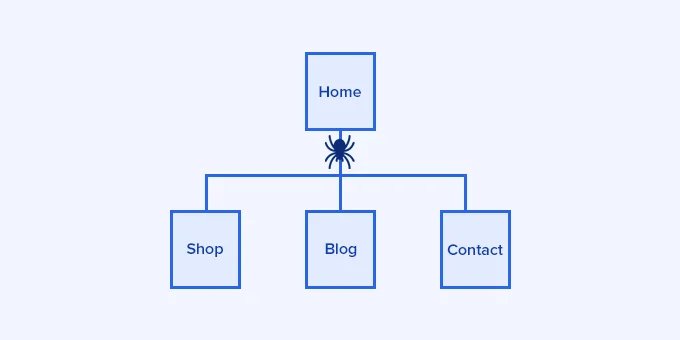

A importância do Crawl Budget

Os motores de busca atribuem uma quota de rastreio específica a cada sítio Web, frequentemente designada por "orçamento de rastreio". Os robots rastreiam um número limitado de páginas por visita e, se esgotarem esta quota em páginas de baixo valor ou irrelevantes, podem perder conteúdos essenciais. Um ficheiro robots.txt bem optimizado ajuda-o a poupar recursos de rastreio para as suas páginas mais valiosas, reduzindo o tempo que os motores de busca demoram a indexar conteúdo novo ou atualizado.

Controlar a visibilidade do conteúdo

O seu ficheiro robots.txt pode ajudá-lo a impedir que os motores de busca indexem determinadas páginas que podem não precisar de aparecer nos resultados de pesquisa, tais como páginas de administração, ficheiros privados ou conteúdo reduzido. No entanto, a utilização do robots.txt para bloquear conteúdo não o esconde totalmente do público; simplesmente impede que os motores de busca o indexem.

Estrutura ideal do ficheiro Robots.txt para WordPress

Uma norma robots.txt para sítios Web WordPress inclui normalmente regras para controlar o acesso a áreas sensíveis e reduzir o rastreio desnecessário. Abaixo está um exemplo que funciona bem para a maioria dos sítios WordPress:

User-Agent: *

Permitir: /wp-content/uploads/

Não permitir: /wp-admin/

Não permitir: /readme.html

Não autorizar: /refer/

Mapa do sítio: https://www.example.com/post-sitemap.xml

Mapa do sítio: https://www.example.com/page-sitemap.xmlPermitir /wp-content/uploads/: Concede acesso a ficheiros multimédia, tais como imagens.

Não permitir /wp-admin/: Impede o acesso ao diretório de administração do WordPress.

Não permita /readme.html: Restringe o acesso ao ficheiro readme do WordPress, que pode conter informações sensíveis sobre a versão.

Não permitir /refer/impedir a indexação de links de afiliados camuflados ou outros URLs que possa querer ocultar.

Métodos para criar e editar um ficheiro Robots.txt no WordPress

Existem várias formas de criar e gerir o seu ficheiro robots.txt no WordPress, permitindo-lhe escolher o método mais adequado aos seus conhecimentos técnicos. Aqui estão três abordagens populares:

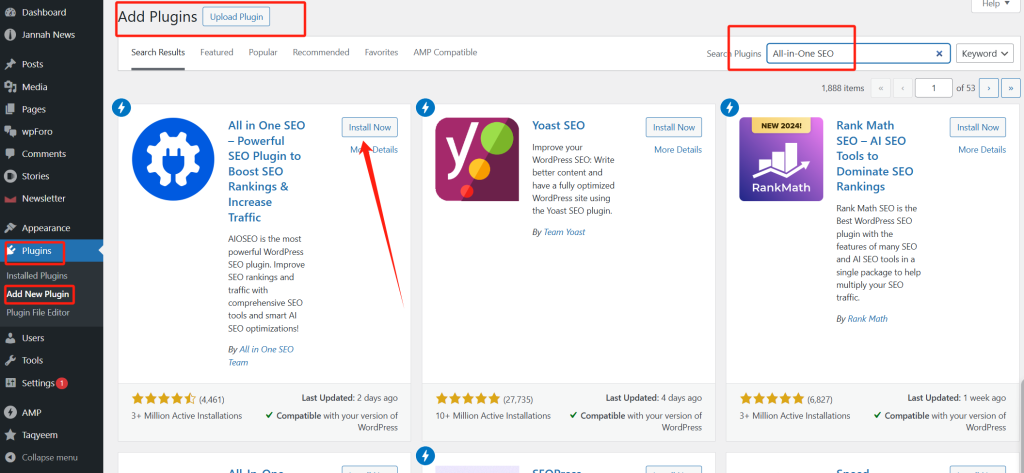

Método 1: Utilizar o plug-in All-in-One SEO (AIOSEO)

O All-in-One SEO (AIOSEO) é um popular plugin de SEO com um editor de robots.txt incorporado, perfeito para principiantes.

1. Instale o AIOSEO.

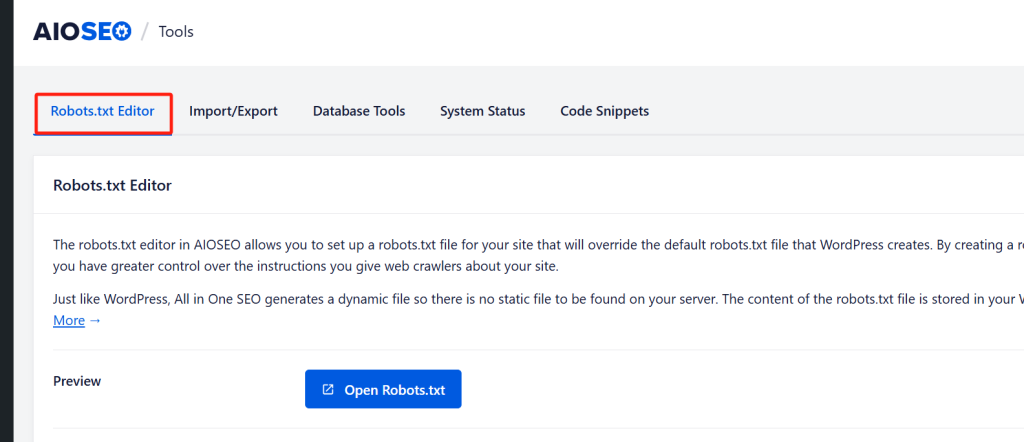

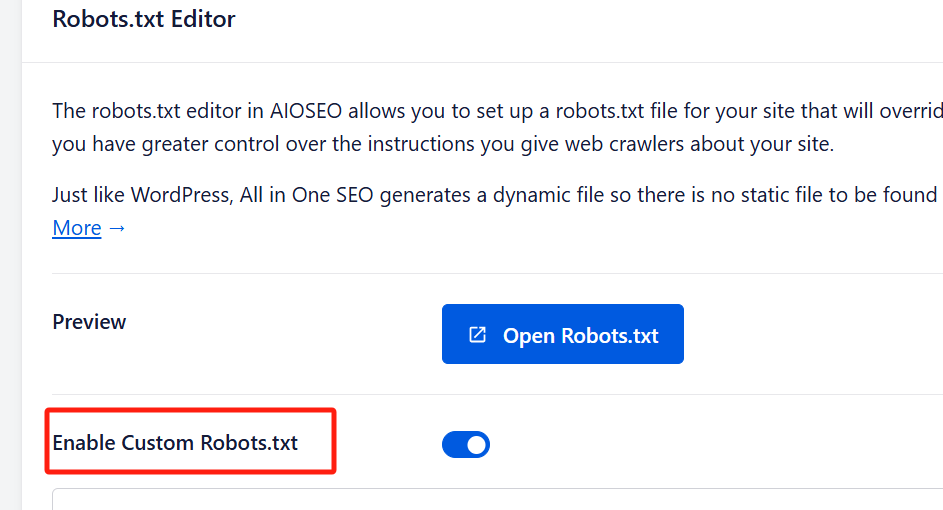

2. Ativar Robots.txt personalizados: Ir para Tudo em um SEO " Ferramentas depois de instalado. Alterne 'Ativar Robots.txt personalizados' para ativar a edição.

3. Editar e personalizar: No editor, adicione regras especificando o agente do utilizador, selecionando "Permitir" ou "Não permitir" e introduzindo caminhos de diretórios.

4. Pré-visualizar e guardar: Verifique a pré-visualização para garantir que as suas alterações estão corretas e, em seguida, clique em 'Guardar alterações'.

O editor AIOSEO é de fácil utilização e inclui uma função de pré-visualização, que lhe permite ver as suas regras antes de as guardar.

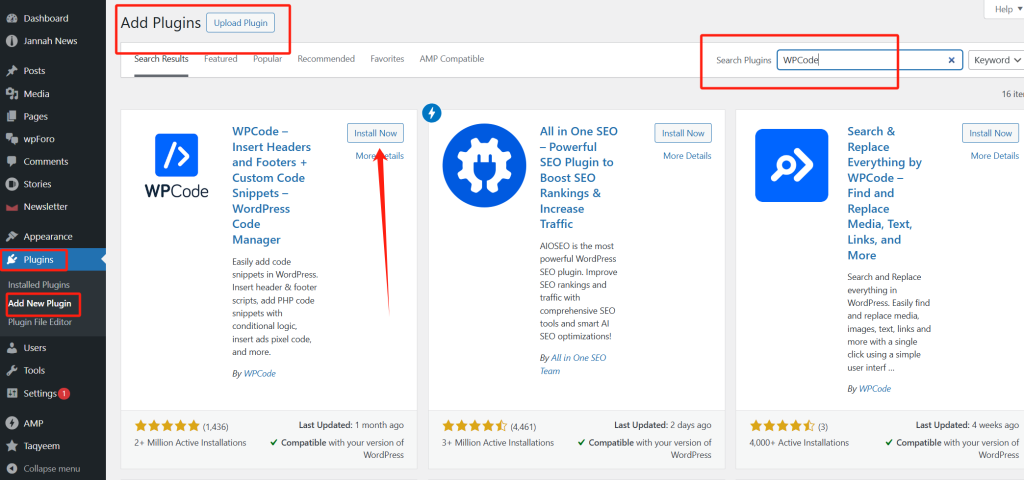

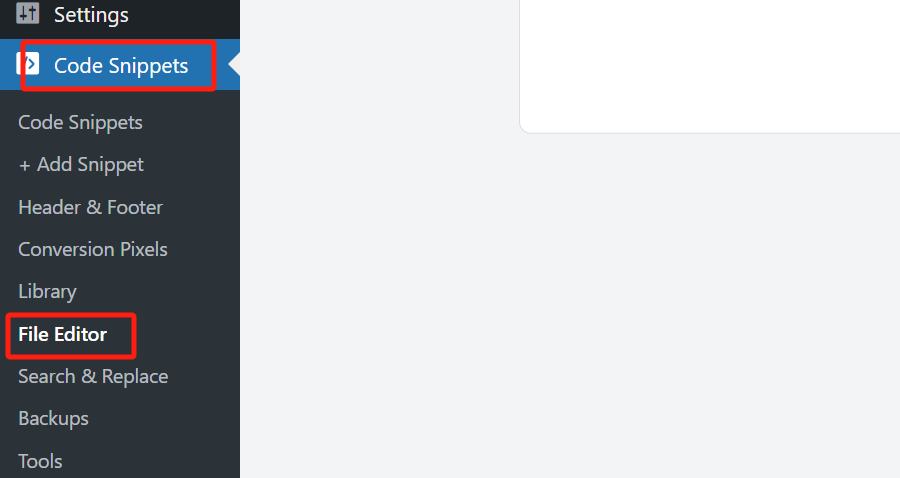

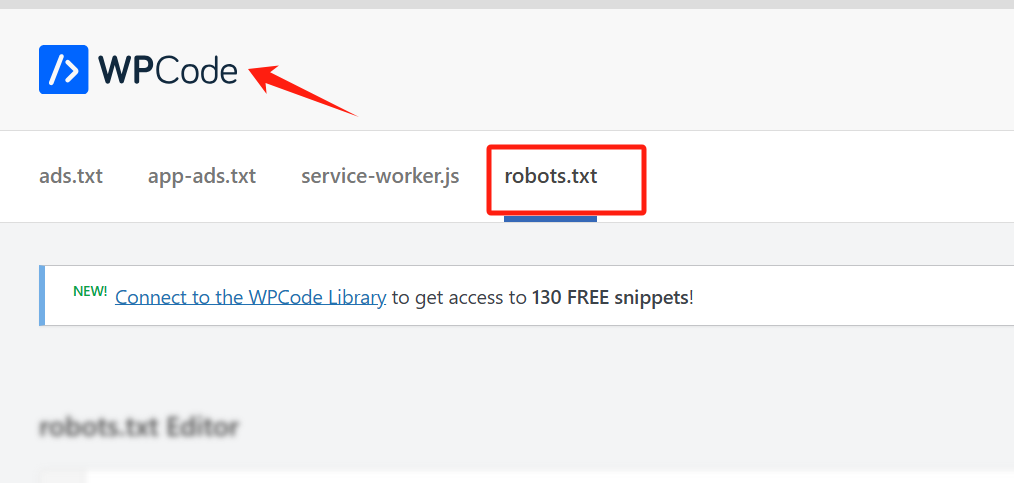

Método 2: Utilizar o WPCode

O WPCode é outro plugin para WordPress que inclui um editor de robots.txt, permitindo-lhe aceder facilmente à gestão de ficheiros sem necessitar de FTP.

1. Instale o WPCode.

2. Abrir o editor de ficheiros: Navegue para WPCode " Editor de ficheiros e selecione o separador robots.txt.

3. Adicione as suas regras: Introduza as suas regras robots.txt conforme necessário.

4. Guardar: Clique em "Guardar alterações" para aplicar as suas definições.

Nota: A versão gratuita do WPCode não inclui o robots.txt por isso, vai precisar da versão premium.

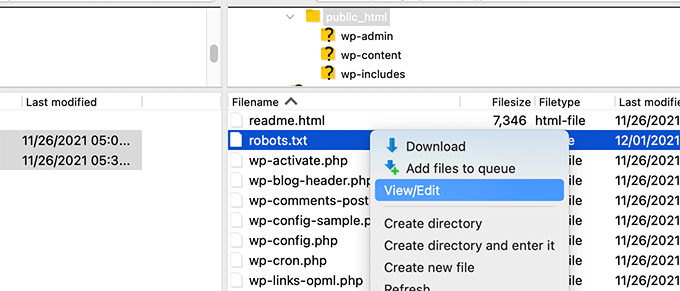

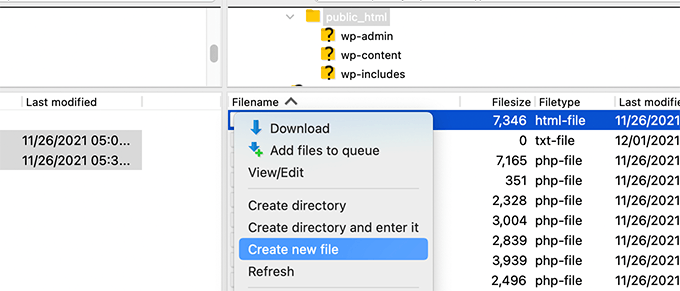

Método 3: Editar manualmente o ficheiro Robots.txt através de FTP

Os utilizadores avançados ou familiarizados com FTP podem criar e carregar manualmente um ficheiro robots.txt.

1. Aceda ao seu site através de FTP: Aceda aos seus ficheiros WordPress utilizando um cliente FTP (por exemplo, FileZilla).

2. Localize ou crie Robots.txt: Encontre o ficheiro no diretório raiz ou crie um novo se não existir.

3. Edite o ficheiro: Descarregue-o, edite-o num editor de texto simples e guarde-o.

4. Carregue o ficheiro atualizado: Volte a carregar o ficheiro no diretório raiz do seu site.

Este método oferece o maior controlo, mas requer familiaridade com FTP e estruturas de diretórios.

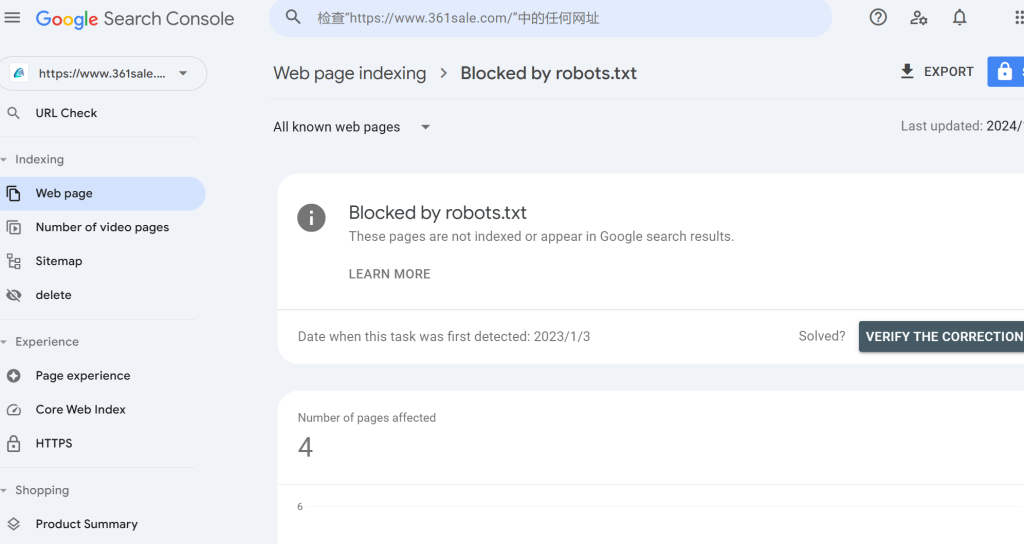

Testar o seu ficheiro Robots.txt quanto a erros

Quando o seu ficheiro robots.txt estiver ativo, é crucial testá-lo para garantir que os motores de busca o interpretam corretamente. A Consola de Pesquisa do Google fornece uma ferramenta de teste de robots.txt incorporada para o ajudar a verificar se existem erros.

1. Ligue o seu site à Consola de Pesquisa do Google: Se ainda não o fez, adicione o seu sítio à Consola de Pesquisa do Google.

2. Aceda à ferramenta de teste de robôs: Abra a ferramenta de teste de robôs na Consola de Pesquisa do Google.

3. Verifique se há erros: A ferramenta vai buscar o seu ficheiro robots.txt e apresenta quaisquer problemas de sintaxe ou avisos.

Erros comuns a evitar na otimização de Robots.txt

Para maximizar o potencial de SEO do seu robots.txt arquivo, evite estas armadilhas comuns:

- Bloqueio de conteúdos essenciais: Evite bloquear páginas ou recursos críticos, como ficheiros CSS e JavaScript. O Google aconselha a permitir que os bots acedam a estes recursos, uma vez que ajudam os motores de busca a compreender a disposição e a funcionalidade do site.

- Bloqueio de páginas de arquivo, etiquetas e categorias: Muitos especialistas em SEO acreditam que o bloqueio de páginas de arquivo melhora a eficiência do rastreio, mas as diretrizes do Google para webmasters sugerem o contrário. Estas páginas acrescentam frequentemente valor à estrutura do site e à experiência do utilizador.

- Não adicionar Sitemaps: Incluir sitemaps XML no seu

robots.txtO ficheiro pode ajudar muito os motores de busca a localizar todo o conteúdo relevante do seu sítio.

Considerações finais sobre a otimização de Robots.txt para SEO

A otimização do seu ficheiro robots.txt pode parecer insignificante, mas o seu impacto na SEO pode ser substancial. Ao orientar os motores de busca sobre onde se devem concentrar, pode garantir que os bots rastejam e indexam eficazmente o seu conteúdo mais importante, melhorando o desempenho geral de SEO do seu site. Utilize os exemplos, métodos e práticas recomendadas discutidos aqui para criar um ficheiro robots.txt optimizado e assumir o controlo da forma como os motores de busca interagem com o seu site WordPress.

Respostas