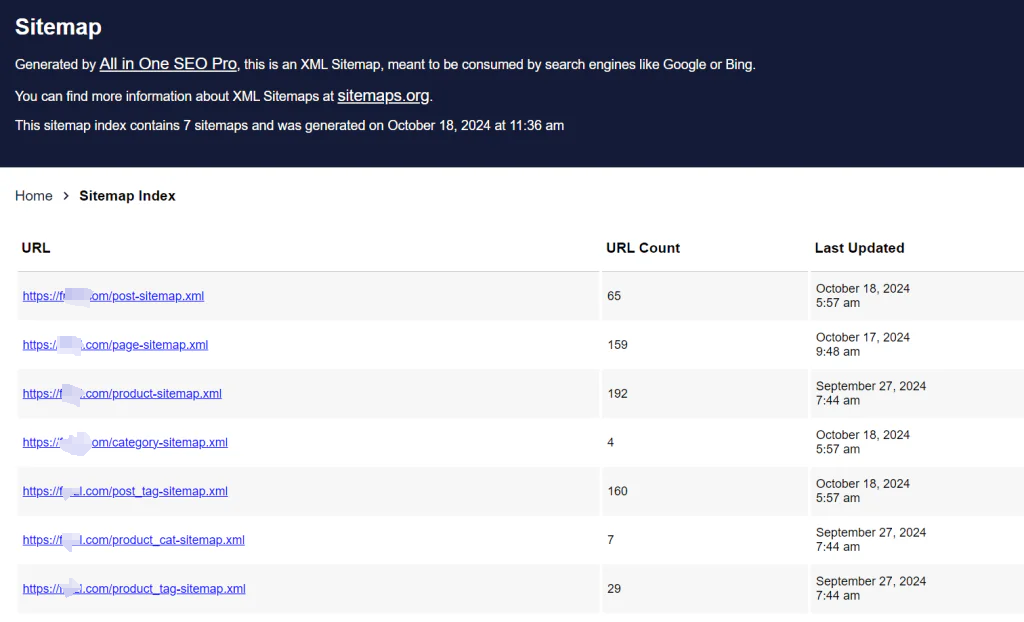

Comprendre les sitemaps et leur importance pour votre site web

A plan du site est un fichier dans lequel vous fournissez des informations sur les pages, les vidéos, les images et les autres fichiers de votre site web, ainsi que sur les relations entre eux. Les moteurs de recherche comme Google utilisent ce fichier pour explorer votre site web plus efficacement. Les sitemaps aident les moteurs de recherche à comprendre quelles pages ou quels fichiers de votre site sont les plus importants et fournissent des détails supplémentaires, comme la date de mise à jour d'une page ou l'existence d'autres versions linguistiques.

Dans un plan du site, vous pouvez fournir des détails sur différents types de contenu, y compris les vidéos, les images et les articles d'actualité. Par exemple, vous pouvez fournir des détails sur les vidéos, les images et les articles d'actualité :

- Sitemaps vidéo peut inclure des informations telles que la durée de la vidéo, les classements et le public visé.

- Image sitemaps peut spécifier l'emplacement des images dans votre page web.

- Nouvelles sitemaps peut indiquer les titres des articles et leur date de publication.

Avez-vous besoin d'un plan du site ?

Un plan du site peut jouer un rôle crucial même si votre site est bien structuré et que les liens internes sont corrects, c'est-à-dire que toutes les pages nécessaires sont accessibles par des liens de navigation (tels que des menus). Il est particulièrement utile pour les sites web complexes et de grande taille ou pour ceux dont le contenu est particulier, comme les médias riches (vidéos et images) ou les actualités.

Vous devriez envisager d'utiliser un sitemap si :

- Votre site web est volumineux: Les sites web de grande taille peuvent comporter des pages qui ne sont pas facilement accessibles par la navigation standard. Il peut être difficile de s'assurer que toutes les pages nécessaires sont liées, ce qui augmente le risque que les moteurs de recherche manquent certaines pages.

- Votre site web est nouveau et manque de liens externes: Les moteurs de recherche comme Google découvrent de nouveaux contenus principalement en suivant les liens d'autres sites web. Si votre site est nouveau et n'a pas beaucoup de liens retour, Googlebot risque de ne pas trouver tout votre contenu à moins que vous ne soumettiez un plan du site (sitemap).

- Votre site web contient des médias riches ou du contenu d'actualité: Si votre site héberge beaucoup de vidéos, d'images ou d'articles d'actualité, un plan du site peut aider Google à trouver et à indexer ces fichiers multimédias. Par exemple, les métadonnées vidéo, telles que la durée et l'audience, peuvent être incluses dans un sitemap vidéo pour aider Google à comprendre ce contenu.

D'un autre côté, vous n'avez peut-être pas besoin d'un sitemap si :

- Votre site web est petit: Si votre site web contient moins de 500 pages et que ces pages sont toutes bien reliées entre elles, Google est susceptible de trouver toutes les pages essentielles sans sitemap.

- Votre site web dispose de liens internes complets: Si toutes vos pages importantes sont facilement accessibles par des liens internes, Googlebot pourra les découvrir sans avoir besoin d'un sitemap.

- Vous avez peu de médias ou d'articles de presse: Un sitemap n'est peut-être pas nécessaire si vous n'avez pas beaucoup de vidéos, d'images ou d'articles d'actualité à indexer.

Comment Googlebot explore votre site

Googlebot est le nom du robot d'exploration de Google, chargé de découvrir et d'indexer le contenu du web. Il existe deux versions :

- Googlebot Mobile: Simule un utilisateur mobile pour explorer la version mobile des sites web.

- Googlebot Desktop: Simule un utilisateur de bureau pour parcourir les versions de bureau des sites web.

Les deux types de Googlebot suivent les mêmes règles dans votre fichier robots.txt. Cependant, comme Google utilise principalement indexation mobile-firstEn effet, la plupart des recherches sont effectuées par la version mobile. Cela signifie que les performances et la structure mobiles de votre site web jouent un rôle crucial dans la manière dont Google indexe votre contenu.

Googlebot parcourt les sites web à un rythme moyen d'une fois toutes les quelques secondes. Cette fréquence peut varier en fonction de la taille de votre site et de la quantité de nouveaux contenus. Google utilise l'informatique distribuée, c'est-à-dire que plusieurs robots travaillent simultanément à partir de différentes adresses IP. Cela permet d'améliorer les performances et de s'assurer que Googlebot ne surcharge pas vos serveurs de requêtes.

Pour optimiser l'exploration, Googlebot peut utiliser HTTP/2 si votre site web le prend en charge, ce qui réduit la charge sur votre serveur et sur le robot d'exploration. Toutefois, l'utilisation de HTTP/2 par rapport à HTTP/1.1 ne présente aucun avantage en termes de classement. Vous pouvez empêcher Googlebot d'explorer votre site via HTTP/2 en renvoyant un message de type 421 Code d'état HTTP lorsqu'une tentative de crawl est effectuée.

Gérer la fréquence et les limites du crawl de Googlebot

Googlebot gère automatiquement son taux d'exploration pour la plupart des sites web afin d'éviter de surcharger votre serveur. Toutefois, si votre serveur ne peut pas répondre aux demandes de Googlebot, vous pouvez utiliser les outils suivants Google Search Console pour réduire la vitesse de défilement.

Googlebot est programmé pour ramper jusqu'à la première page du site. 15MB d'un fichier HTML ou d'un fichier texte pris en charge. Une fois cette limite atteinte, Googlebot cesse d'explorer le fichier et seuls les 15 premiers Mo sont pris en compte pour l'indexation. Il est important de noter que cette limite s'applique aux données non compressées. Par conséquent, si vos pages sont énormes, vous pouvez optimiser vos fichiers pour vous assurer que tout le contenu essentiel se trouve dans les 15 premiers Mo.

Bloquer l'exploration de certaines pages par Googlebot

Si vous souhaitez empêcher Googlebot d'explorer des pages spécifiques de votre site, plusieurs options s'offrent à vous :

- Utilisez le fichier robots.txt: En spécifiant des règles dans le fichier robots.txt, vous pouvez empêcher Googlebot d'explorer certaines pages.

- Utilisez la directive noindex. Cette directive garantit que certaines pages n'apparaîtront pas dans les résultats de recherche de Google, même si elles sont explorées.

- Utiliser la protection par mot de passe: La protection par mot de passe de ces pages est une solution efficace pour empêcher les robots d'indexation et les utilisateurs d'accéder à certains contenus.

Vérifier l'identité de Googlebot

Il est essentiel de vérifier l'authenticité des demandes prétendant provenir de Googlebot, car d'autres robots d'indexation peuvent usurper l'identité de Googlebot. La meilleure façon de confirmer qu'une requête provient de Google est de vérifier le champ l'adresse IP de la demande et vérifiez-le par rapport à la liste officielle de Google. Adresses IP de Googlebot.

Conclusion : Un plan du site est-il nécessaire pour votre site web ?

En conclusion, bien que Google puisse souvent trouver et explorer votre site web sans sitemap, il existe des situations où l'utilisation d'un sitemap est très bénéfique. Pour les sites web nouveaux ou de grande taille, ou pour ceux qui contiennent un contenu multimédia riche, un sitemap est un outil précieux qui aide les moteurs de recherche tels que Google à découvrir et à hiérarchiser votre contenu de manière plus efficace. En fournissant un sitemap détaillé, vous vous assurez que vos pages les plus importantes sont indexées et visibles dans les résultats de recherche, ce qui peut améliorer les performances de votre site web dans les classements de recherche.

Réponses