Comment optimiser votre fichier Robots.txt pour un meilleur référencement sur WordPress

Le fichier robots.txt est un élément clé du référencement que les débutants négligent souvent. Ce fichier apparemment simple joue un rôle vital en guidant les moteurs de recherche sur les parties de votre site Web auxquelles ils doivent accéder, qu'ils doivent explorer et indexer, ce qui vous permet d'économiser de précieuses ressources d'exploration et d'améliorer le référencement de votre site WordPress.

Ce guide complet vous expliquera pourquoi et comment optimiser votre fichier robots.txt, les meilleures pratiques à suivre, les erreurs courantes à éviter et les méthodes pour le créer ou le modifier dans WordPress.

Qu'est-ce qu'un fichier Robots.txt et pourquoi est-il important pour le référencement ?

A robots.txt est un fichier texte stocké dans le répertoire racine de votre site web qui indique aux moteurs de recherche comment explorer certaines parties de votre site. En contrôlant ce à quoi les moteurs de recherche peuvent accéder, un fichier robots.txt peut :

- Aidez les moteurs de recherche à se concentrer sur vos pages les plus importantes, améliorant ainsi les performances de référencement.

- Empêchez les moteurs de recherche de gaspiller des ressources sur des pages inutiles ou de faible valeur.

- Contrôlez le contenu qui apparaît dans les résultats de recherche, ce qui vous aide à gérer l'image publique de votre site.

Sans un robots.txt les moteurs de recherche parcourront toujours votre site, mais vous n'aurez pas la possibilité de les détourner des pages qui ne contribuent pas à vos objectifs de référencement.

Éléments essentiels d'un fichier Robots.txt

Un fichier robots.txt contient des instructions à l'intention des robots des moteurs de recherche, ou "agents utilisateurs", précisant quelles parties de votre site doivent être explorées ou ignorées. Voici une décomposition simple des composants :

- User-agent: Indique à quel bot du moteur de recherche la règle s'applique (par exemple, Googlebot pour le bot de Google).

- Désactiver: Empêche les robots d'accéder à des URL ou à des répertoires spécifiques.

- Permettre: Permet aux robots d'explorer des URL spécifiques, ce qui permet d'outrepasser les règles Disallow.

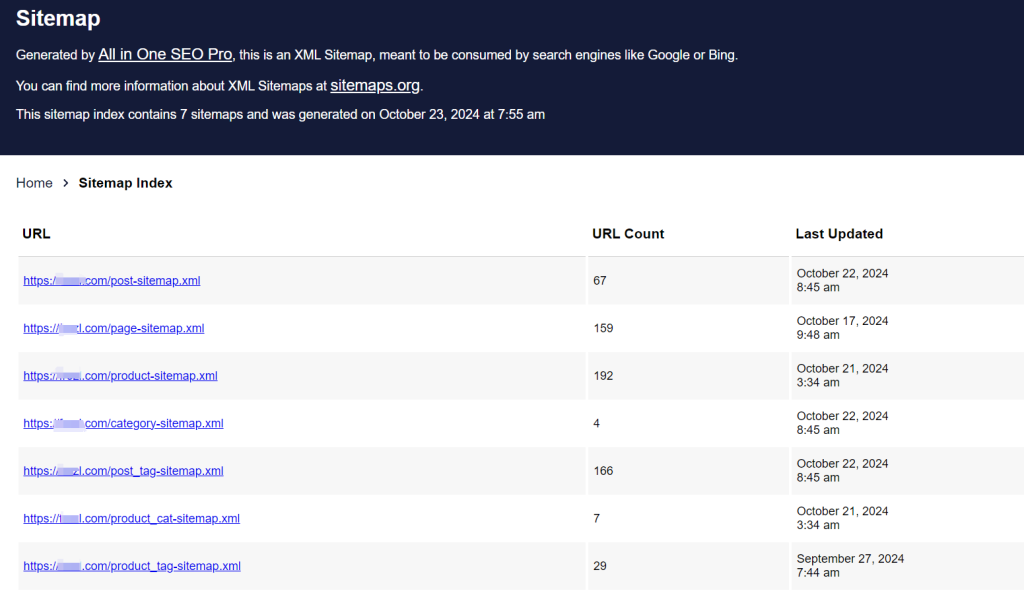

- Plan du site: Indique l'emplacement de votre sitemap XML, qui fournit aux moteurs de recherche une liste complète des URL de votre site pour en faciliter la découverte et l'indexation.

Exemple de structure de fichier Robots.txt

Voici la structure de base d'un robots.txt file:

User-agent : [nom de l'agent]

Disallow : [chaîne d'URL à ne pas explorer]

User-agent : [nom du user-agent]

Allow : [chaîne d'URL à explorer]

Sitemap : [URL de votre Sitemap XML]

Par exemple, dans le cas d'un site WordPress, un fichier typique robots.txt peut se présenter comme suit :

User-agent : *

Autoriser : /wp-content/uploads/

Disallow : /wp-content/plugins/

Disallow : /wp-content/uploads/ : /wp-admin/

Plan du site : https://example.com/sitemap_index.xmlCet exemple permet aux robots d'accéder aux fichiers multimédias dans la section /uploads/ restreint l'accès au répertoire /plugins/ et /admin/ et inclut l'URL du sitemap pour permettre aux robots de trouver facilement les URL de votre site.

Pourquoi avez-vous besoin d'un fichier Robots.txt pour votre site WordPress ?

Un fichier robots.txt n'est pas nécessaire pour que les moteurs de recherche parcourent votre site. Toutefois, si vous en avez un, vous pourrez guider les robots de manière plus efficace. Pour les sites plus importants ou les sites à la structure complexe, un fichier robots.txt est essentiel pour économiser les ressources d'exploration, donner la priorité aux pages de grande valeur et veiller à ce que les moteurs de recherche n'accèdent pas au contenu superflu.

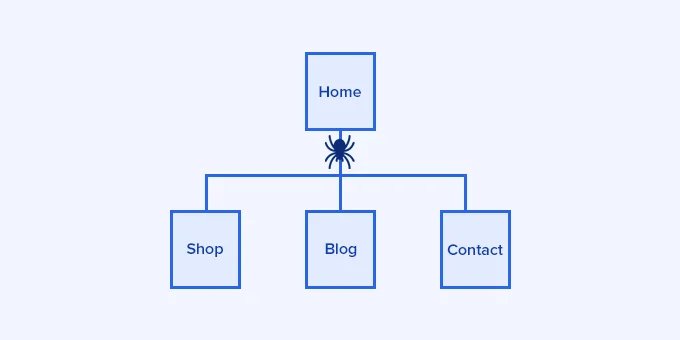

L'importance du budget Crawl

Les moteurs de recherche attribuent à chaque site web un quota d'exploration spécifique, souvent appelé "budget d'exploration". Les robots parcourent un nombre limité de pages par visite et s'ils épuisent ce quota sur des pages de faible valeur ou non pertinentes, ils risquent de passer à côté d'un contenu essentiel. Un fichier robots.txt bien optimisé vous permet d'économiser des ressources d'exploration pour vos pages les plus importantes, réduisant ainsi le temps nécessaire aux moteurs de recherche pour indexer un contenu nouveau ou mis à jour.

Contrôler la visibilité du contenu

Votre fichier robots.txt peut vous aider à empêcher les moteurs de recherche d'indexer certaines pages qui n'ont pas besoin d'apparaître dans les résultats de recherche, telles que les pages d'administration, les fichiers privés ou le contenu superficiel. Toutefois, l'utilisation de robots.txt pour bloquer un contenu ne le cache pas entièrement au public ; il empêche simplement les moteurs de recherche de l'indexer.

Structure idéale du fichier Robots.txt pour WordPress

Une norme robots.txt pour les sites WordPress comprend généralement des règles permettant de contrôler l'accès aux zones sensibles et de réduire l'exploration inutile. Vous trouverez ci-dessous un exemple qui fonctionne bien pour la plupart des sites WordPress :

User-Agent : *

Autoriser : /wp-content/uploads/

Disallow : /wp-admin/

Disallow : /wp-content/uploads/ Disallow : /wp-admin/ Disallow /readme.html

Disallow : /wp-admin/ Disallow : /readme.html /refer/

Plan du site : https://www.example.com/post-sitemap.xml

Plan du site : https://www.example.com/page-sitemap.xmlAutoriser /wp-content/uploads/: Permet d'accéder aux fichiers multimédias tels que les images.

Disallow /wp-admin/: Empêche l'accès au répertoire d'administration de WordPress.

Interdire /readme.html: Restreint l'accès au fichier readme de WordPress, qui peut contenir des informations sensibles sur la version.

Interdire /refer/empêcher l'indexation de liens d'affiliation masqués ou d'autres URL que vous souhaitez dissimuler.

Méthodes pour créer et modifier un fichier Robots.txt dans WordPress

Il existe plusieurs façons de créer et de gérer votre fichier robots.txt sur WordPress, ce qui vous permet de choisir la méthode qui correspond à votre expertise technique. Voici trois approches populaires :

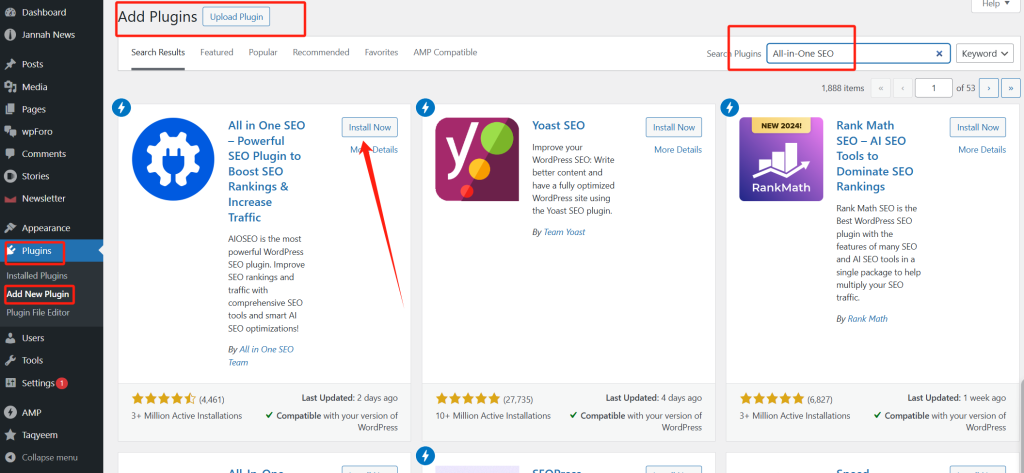

Méthode 1 : Utiliser le plugin All-in-One SEO (AIOSEO)

All-in-One SEO (AIOSEO) est un plugin SEO populaire avec un éditeur robots.txt intégré, parfait pour les débutants.

1. Installer AIOSEO.

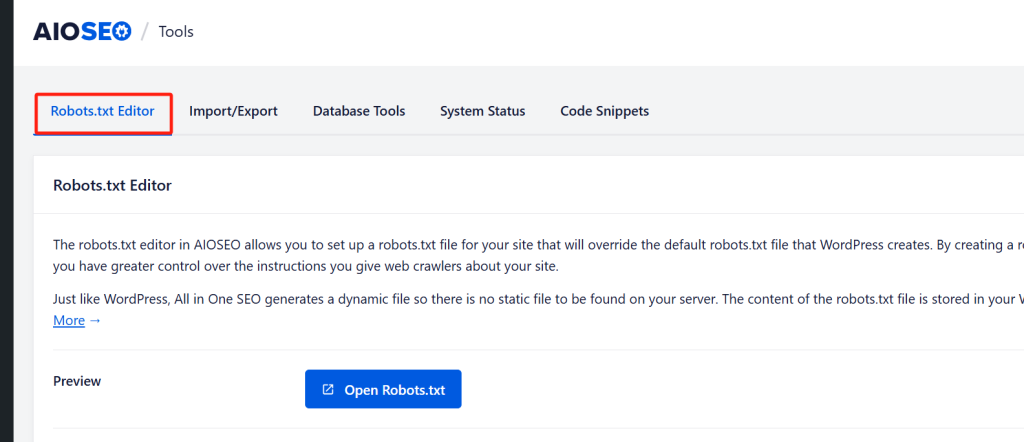

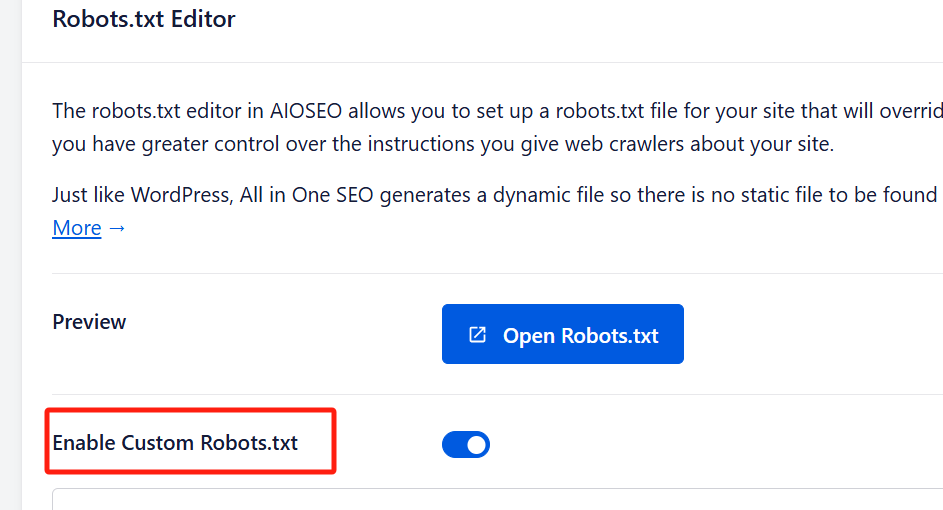

2. Activer le fichier Robots.txt personnalisé: Aller à Outils " SEO " tout-en-un une fois installé. Activez l'option "Enable Custom Robots.txt" pour activer l'édition.

3. Modifier et personnaliser: Dans l'éditeur, ajoutez des règles en spécifiant l'agent utilisateur, en sélectionnant "Allow" ou "Disallow" et en saisissant les chemins d'accès aux répertoires.

4. Prévisualisation et enregistrement: Vérifiez l'aperçu pour vous assurer que vos modifications sont exactes, puis cliquez sur "Enregistrer les modifications".

L'éditeur AIOSEO est convivial et comprend une fonction de prévisualisation qui vous permet de voir vos règles avant de les enregistrer.

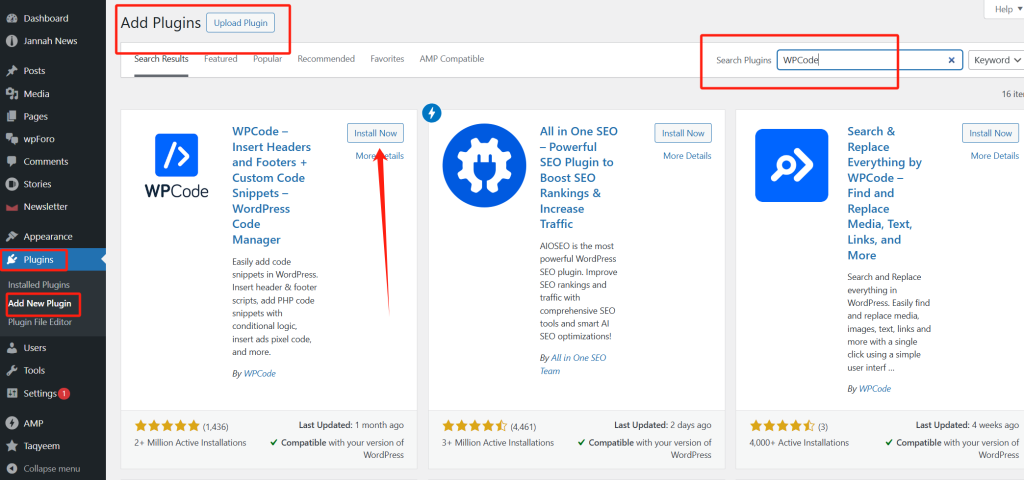

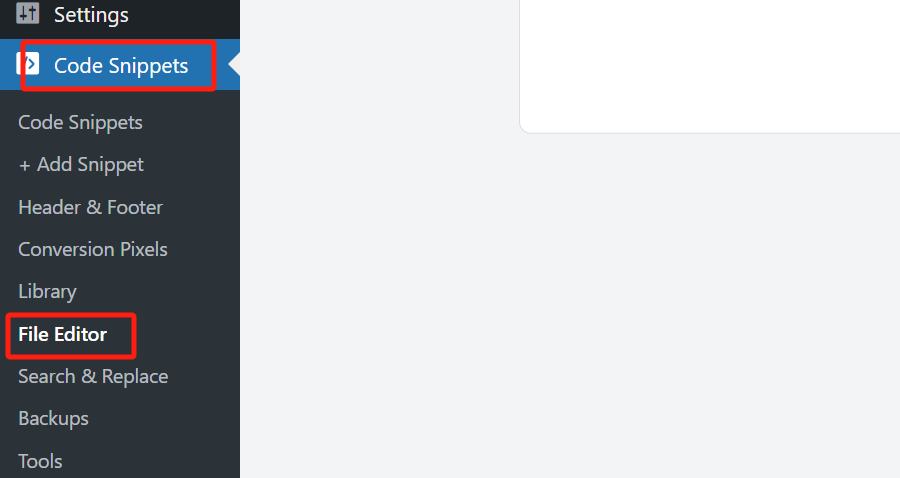

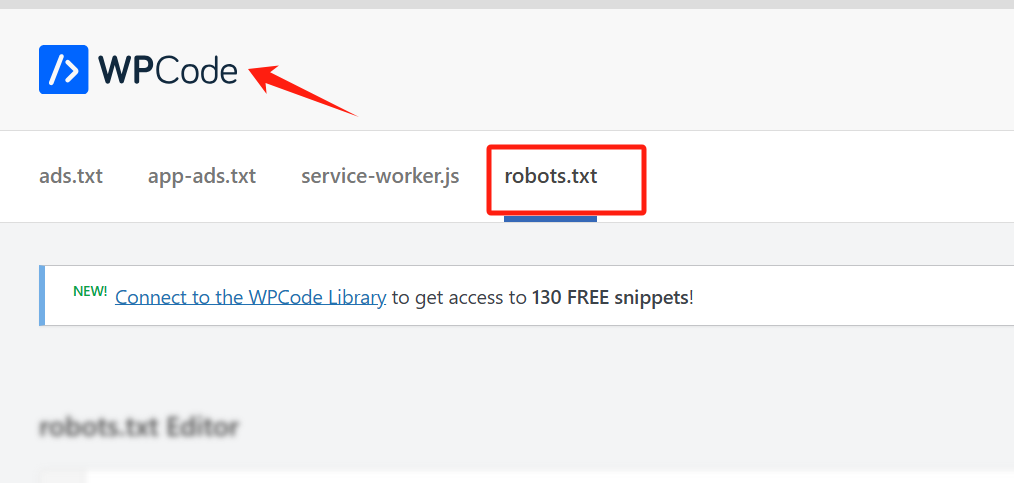

Méthode 2 : Utilisation de WPCode

WPCode est un autre plugin WordPress qui inclut un éditeur robots.txt, permettant un accès facile à la gestion des fichiers sans avoir recours au FTP.

1. Installer WPCode.

2. Ouvrir l'éditeur de fichiers: Naviguez vers WPCode " Éditeur de fichiers et sélectionnez l'onglet robots.txt.

3. Ajouter vos règles: Saisissez vos règles robots.txt si nécessaire.

4. Économiser: Cliquez sur "Enregistrer les modifications" pour appliquer vos paramètres.

Remarque : la version gratuite de WPCode ne comprend pas la fonction robots.txt vous aurez besoin de la version premium.

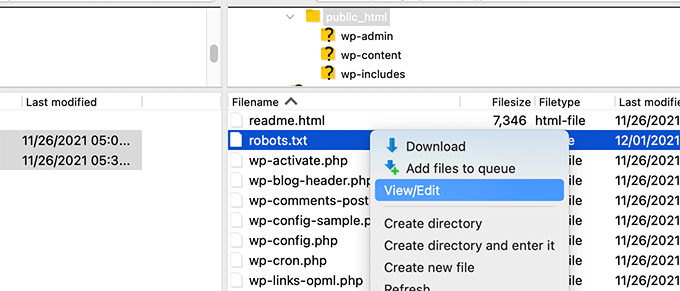

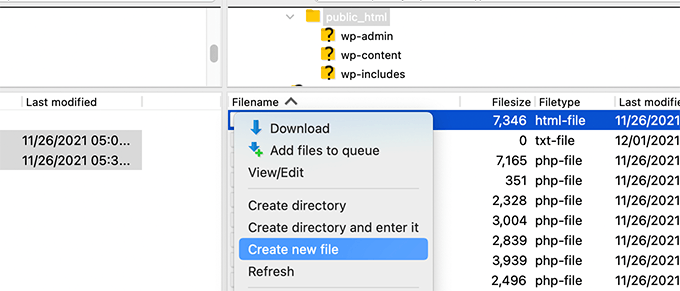

Méthode 3 : Modification manuelle de Robots.txt via FTP

Les utilisateurs avancés ou ceux qui connaissent le FTP peuvent créer et télécharger manuellement un fichier robots.txt.

1. Accédez à votre site via FTP: Accédez à vos fichiers WordPress à l'aide d'un client FTP (par exemple, FileZilla).

2. Localisez ou créez Robots.txt: Recherchez le fichier dans le répertoire racine ou créez-en un nouveau s'il n'existe pas.

3. Modifier le fichier: Téléchargez-le, modifiez-le dans un éditeur de texte simple et enregistrez-le.

4. Télécharger le fichier mis à jour: Recharger le fichier dans le répertoire racine de votre site.

Cette méthode offre le plus de contrôle, mais nécessite une certaine familiarité avec le FTP et les structures de répertoire.

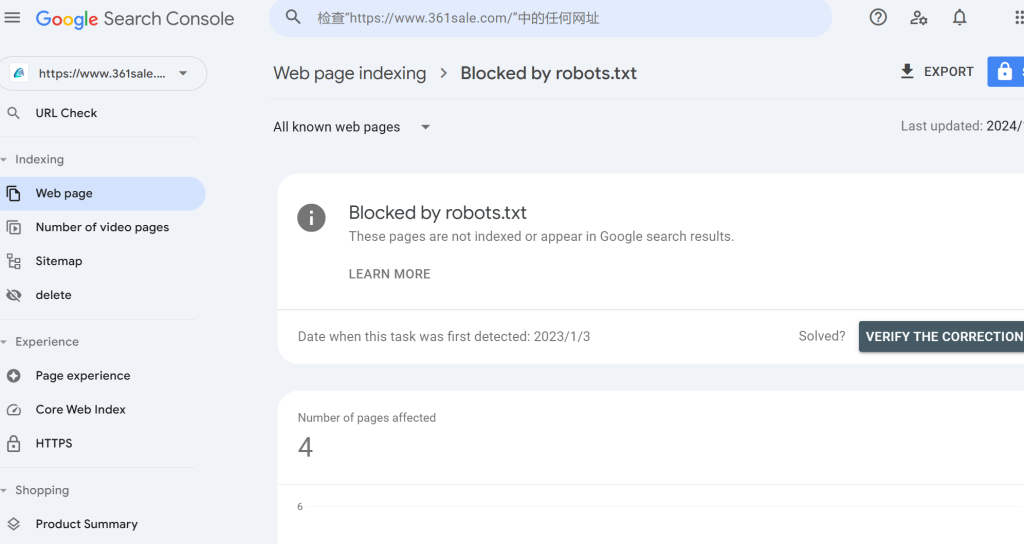

Tester votre fichier Robots.txt pour vérifier qu'il ne contient pas d'erreurs

Une fois que votre fichier robots.txt est en ligne, il est essentiel de le tester pour s'assurer que les moteurs de recherche l'interprètent correctement. La Search Console de Google propose un outil intégré de test du fichier robots.txt qui vous permet de vérifier s'il y a des erreurs.

1. Lier votre site à Google Search Console: Si vous ne l'avez pas encore fait, ajoutez votre site à Google Search Console.

2. Accéder à l'outil de test des robots: Ouvrez l'outil de test des robots dans la Search Console de Google.

3. Vérifier les erreurs: L'outil récupère votre fichier robots.txt et affiche les éventuels problèmes de syntaxe ou avertissements.

Erreurs courantes à éviter dans l'optimisation de Robots.txt

Pour maximiser le potentiel de référencement de votre robots.txt évitez ces pièges courants :

- Blocage du contenu essentiel: Évitez de bloquer les pages ou les ressources critiques telles que les fichiers CSS et JavaScript. Google conseille de permettre aux robots d'accéder à ces ressources, car elles aident les moteurs de recherche à comprendre la présentation et la fonctionnalité du site.

- Blocage des pages d'archives, d'étiquettes et de catégories: De nombreux experts en référencement pensent que le blocage des pages d'archives améliore l'efficacité du crawl, mais les directives de Google à l'intention des webmasters suggèrent le contraire. Ces pages apportent souvent une valeur ajoutée à la structure du site et à l'expérience de l'utilisateur.

- Ne pas ajouter de sitemaps: Inclure des sitemaps XML dans votre

robots.txtpeut grandement aider les moteurs de recherche à localiser tout le contenu pertinent de votre site.

Dernières réflexions sur l'optimisation de Robots.txt pour le référencement

L'optimisation de votre fichier robots.txt peut sembler mineure, mais son impact sur le référencement peut être considérable. En indiquant aux moteurs de recherche où se concentrer, vous pouvez vous assurer que les robots explorent et indexent efficacement votre contenu le plus important, améliorant ainsi les performances globales de votre site en matière de référencement. Utilisez les exemples, les méthodes et les meilleures pratiques présentés ici pour créer un fichier robots.txt optimisé et prendre le contrôle de la façon dont les moteurs de recherche interagissent avec votre site WordPress.

Réponses