Comment rédiger et soumettre un fichier robots.txt ?

Contrôler ce que les moteurs de recherche peuvent ou ne peuvent pas explorer est un élément essentiel de la gestion de votre présence en ligne. L'un des moyens les plus efficaces consiste à utiliser un fichier robots.txt. Ce fichier texte indique aux moteurs de recherche les parties de votre site web auxquelles ils peuvent accéder et celles auxquelles ils ne peuvent pas accéder, ce qui vous aide à orienter le trafic, à protéger le contenu sensible et à améliorer le référencement de votre site.

Dans ce blog, nous allons nous pencher sur l'importance d'un fichier robots.txt, sur la manière d'en créer un et de le personnaliser pour qu'il réponde à vos besoins. Que vous soyez débutant ou expérimenté dans la gestion de sites web, ce guide vous aidera à faire en sorte que votre site soit exploré efficacement par les moteurs de recherche.

Qu'est-ce qu'un fichier Robots.txt ?

A fichier robots.txt est un simple fichier texte placé dans le répertoire racine de votre site web. Il a pour but d'indiquer aux robots d'indexation (tels que Googlebot) les parties de votre site qu'ils peuvent visiter et indexer. À la suite de la création d'un Norme d'exclusion des robotsCe fichier vous permet de contrôler l'accès à des répertoires ou à des pages spécifiques tout en veillant à ce que le contenu essentiel reste accessible aux moteurs de recherche pour l'indexation.

Par exemple, si votre site web est www.example.comVotre fichier robots.txt doit se trouver à l'adresse suivante www.example.com/robots.txt.

Comment fonctionne un fichier Robots.txt ?

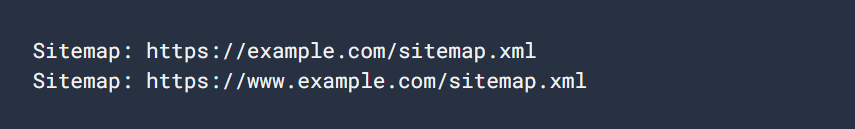

Un fichier robots.txt se compose d'une série de règles, chacune d'entre elles précisant si un robot d'exploration (appelé "agent utilisateur") peut accéder à des parties spécifiques de votre site web. Les règles comprennent des commandes telles que Désactiver, Permettreet Plan du sitequi peut restreindre ou autoriser l'accès à divers URL.

Prenons un exemple simple de fichier robots.txt :

User-agent : Googlebot

Disallow : /nogooglebot/

User-agent : *

Allow : /

Plan du site : https://www.example.com/sitemap.xmlExplication du fichier :

- Googlebot (le robot d'exploration de Google) ne peut pas explorer les URL qui commencent par https://www.example.com/nogooglebot/.

- Tous les autres agents utilisateurs (marqués par *ce qui signifie "tous les robots") peuvent parcourir l'ensemble du site.

- Le plan du site se trouve à l'adresse suivante https://www.example.com/sitemap.xml.

S'il n'existe pas de fichier robots.txt, tous les robots d'exploration peuvent accéder à l'ensemble du site web par défaut. Le fichier robots.txt précise ces autorisations.

Pourquoi avez-vous besoin d'un fichier Robots.txt ?

L'utilisation d'un fichier robots.txt présente plusieurs avantages :

- Contrôle de la reptation: Il vous permet de gérer les parties de votre site qui sont explorées par les moteurs de recherche, ce qui réduit la charge sur votre serveur et empêche l'indexation de contenus sensibles.

- Améliorer le référencement: Vous pouvez concentrer les robots des moteurs de recherche sur les pages les plus importantes de votre site web, en veillant à ce qu'ils indexent le bon contenu pour améliorer votre classement dans les moteurs de recherche.

- Protéger les contenus sensibles: Bien qu'un fichier robots.txt ne puisse pas empêcher l'accès à des données sensibles, il peut aider à cacher des pages privées aux robots des moteurs de recherche, comme les pages de connexion ou les sections d'administration.

Comment créer un fichier Robots.txt ?

La création d'un fichier robots.txt est facile, et vous pouvez le faire à l'aide de n'importe quel éditeur de texte tel que Bloc-notes, TextEdit, viou Emacs. Évitez d'utiliser des traitements de texte tels que Microsoft Word, car ils peuvent introduire un formatage susceptible d'interférer avec le bon fonctionnement du fichier.

1. Créer le fichier

Ouvrez votre éditeur de texte et enregistrez un fichier nommé robots.txt. Veillez à ce qu'il soit codé en UTF-8 format.

2. Ajouter des règles

Commencez à ajouter des règles en spécifiant les agents utilisateurs auxquels elles s'appliquent et les parties de votre site qu'ils sont autorisés (ou non) à explorer.

Voici un exemple de la manière dont vous pouvez empêcher tous les robots d'indexation d'accéder à un répertoire spécifique :

User-agent : *

Disallow : /private-directory/3. Télécharger le fichier

Téléchargez le robots.txt dans le répertoire racine de votre site web. Par exemple, si votre site est www.example.comle fichier doit se trouver à l'adresse www.example.com/robots.txt. Si vous ne savez pas comment accéder au répertoire racine, contactez votre hébergeur.

4. Testez le fichier

Après avoir téléchargé le fichier, vous pouvez le tester en ouvrant un navigateur en mode privé et en vous rendant à l'adresse suivante https://www.example.com/robots.txt. Si vous pouvez visualiser le fichier, cela signifie qu'il a été téléchargé avec succès.

Règles courantes de Robots.txt

Voici quelques règles courantes utilisées dans les fichiers robots.txt :

1. Bloquer tous les robots d'indexation sur l'ensemble du site

User-agent : *

Disallow : /Cette règle empêche tous les robots d'indexation d'accéder à l'ensemble du site web. Soyez prudent avec cette règle, car elle empêche les moteurs de recherche d'indexer votre contenu.

2. Permettre à tous les robots d'accéder à l'ensemble du site

User-agent : *

Autoriser : /Cette règle permet à tous les robots d'indexation d'accéder à l'ensemble de votre site web. Il s'agit du comportement par défaut si vous ne spécifiez aucune règle dans votre fichier robots.txt.

3. Bloquer un répertoire spécifique

User-agent : *

Disallow : /private-directory/Cette règle empêche tous les robots d'accéder au site Web de la /private-directory/. N'oubliez pas que la barre oblique finale indique que tout ce qui se trouve à l'intérieur du répertoire est également interdit.

4. Autoriser un répertoire spécifique, bloquer le reste

User-agent : *

Disallow : /

Autoriser : /public/Cette règle bloque l'accès à l'ensemble du site, à l'exception de la section /public/ répertoire. Cette fonction est utile lorsque vous souhaitez que la majeure partie de votre site reste privée, mais que des pages publiques spécifiques puissent être indexées.

5. Bloquer une page spécifique

User-agent : *

Disallow : /useless_page.htmlCette règle empêche tous les robots d'accéder à une page spécifique de votre site.

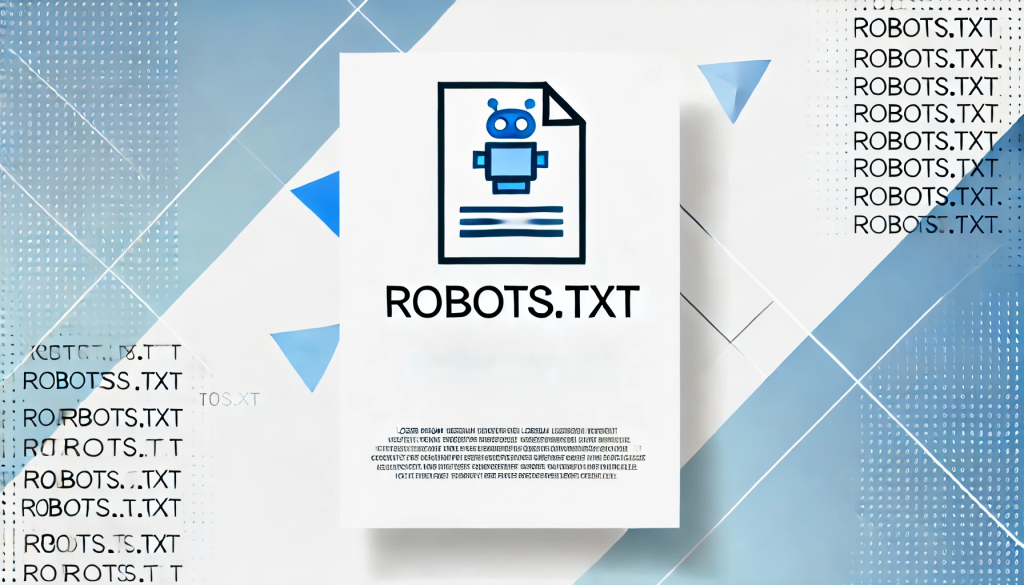

6. Spécifier un plan du site

Plan du site : https://www.example.com/sitemap.xmlL'inclusion d'un plan du site dans votre fichier robots.txt permet aux moteurs de recherche de localiser et d'explorer rapidement toutes les pages essentielles de votre site.

Bonnes pratiques pour les fichiers Robots.txt

Lorsque vous créez votre fichier robots.txt, gardez à l'esprit les meilleures pratiques suivantes :

- Soyez précis: Ne bloquez que les pages ou les répertoires que vous ne souhaitez pas voir explorés par les moteurs de recherche.

- Utiliser le bon cas: Les règles sont sensibles à la casse, donc Ne pas autoriser : /Privé/ et Ne pas autoriser : /private/ bloqueront différents répertoires.

- N'utilisez pas Robots.txt pour les données sensibles: Un fichier robots.txt est public et peut être consulté par n'importe qui. Si vous avez du contenu sensible, comme des pages de connexion ou des zones d'administration, utilisez des méthodes d'authentification appropriées pour les protéger au lieu de vous fier à robots.txt.

- Mise à jour régulière: Veillez à ce que votre fichier robots.txt soit mis à jour en fonction des modifications apportées à la structure de votre site web.

Comment tester et soumettre votre fichier Robots.txt

Après avoir téléchargé votre fichier robots.txt, vous pouvez tester sa validité à l'aide de la commande Testeur de robots.txt de Google Search Console. Cet outil permet de s'assurer que votre fichier est correctement formaté et que Google peut l'interpréter correctement.

Pour soumettre votre fichier robots.txt à Google :

- Accédez à Google Search Console.

- Utilisez le Testeur Robots.txt pour valider votre fichier.

- Une fois validé, Google trouvera et utilisera automatiquement votre fichier robots.txt.

Conclusion

Un fichier robots.txt bien structuré est un outil puissant pour gérer la façon dont les moteurs de recherche interagissent avec votre site. En comprenant comment créer et configurer ce fichier, vous pouvez vous assurer que votre site est optimisé pour l'exploration tout en cachant les contenus sensibles ou inutiles aux robots des moteurs de recherche.

Que vous gériez un blog personnel ou un grand site web d'entreprise, un fichier robots.txt correctement mis en œuvre peut améliorer votre référencement, protéger le contenu sensible et garantir le bon fonctionnement de votre site. Examinez et mettez régulièrement à jour le fichier pour l'adapter à la croissance et aux changements de votre site.

Réponses