كيفية كتابة ملف robots.txt وإرساله

يعد التحكم في ما يمكن لمحركات البحث الزحف إليه وما لا يمكن لمحركات البحث الزحف إليه جزءًا أساسيًا من إدارة وجودك على الإنترنت. إحدى أكثر الطرق فعالية للقيام بذلك هي استخدام ملف robots.txt. يخبر هذا الملف النصي العادي محركات البحث بأجزاء موقعك الإلكتروني التي يمكنهم الوصول إليها والأجزاء التي لا يمكنهم الوصول إليها، مما يساعدك على توجيه حركة المرور وحماية المحتوى الحساس وتحسين تحسين محركات البحث لموقعك.

في هذه المدونة، سنتناول في هذه المدونة أهمية ملف robots.txt، وكيفية إنشاء ملف، وكيفية تخصيصه ليناسب احتياجاتك. سواء كنت مبتدئًا أو شخصًا لديه خبرة في إدارة مواقع الويب، سيساعدك هذا الدليل على ضمان أن محركات البحث تزحف إلى موقعك بفعالية.

ما هو ملف Robots.txt؟

A ملف robots.txt هو ملف نصي بسيط يوضع في الدليل الجذر لموقعك الإلكتروني. والغرض منه هو إرشاد برامج زحف الويب (مثل Googlebot من Google) إلى أجزاء موقعك التي يمكنهم زيارتها وفهرستها. باتباع معيار استبعاد الروبوتات، يساعدك هذا الملف على التحكم في الوصول إلى دلائل أو صفحات معينة مع ضمان بقاء المحتوى المهم متاحًا لمحركات البحث للفهرسة.

على سبيل المثال، إذا كان موقع الويب الخاص بك www.example.com، يجب أن يكون ملف robots.txt الخاص بك في www.example.com/robots.txt.

كيف يعمل ملف Robots.txt؟

يتكون ملف robots.txt من سلسلة من القواعد، حيث تحدد كل قاعدة ما إذا كان يمكن لزاحف ويب معين (يسمى "وكيل المستخدم") الوصول إلى أجزاء معينة من موقعك الإلكتروني. تتضمن القواعد أوامر مثل عدم السماح, السماحو خريطة الموقع، والتي يمكنها إما تقييد الوصول إلى عناوين URL المختلفة أو السماح بالوصول إليها.

لنلقِ نظرة على مثال بسيط لملف robots.txt:

وكيل المستخدم: جوجل بوت

عدم السماح: /nogooglebot/

وكيل المستخدم: *

السماح: /

خريطة الموقع: https://www.example.com/sitemap.xmlشرح الملف:

- جوجل بوت (زاحف غوغل) لا يمكنه الزحف إلى أي عنوان URL يبدأ ب https://www.example.com/nogooglebot/.

- جميع وكلاء المستخدمين الآخرين (المميزة ب *، مما يعني أن "جميع برامج الزحف") يمكنها الزحف إلى الموقع بأكمله.

- توجد خريطة الموقع الخاصة بالموقع في https://www.example.com/sitemap.xml.

في حالة عدم وجود ملف robots.txt، يمكن لجميع برامج الزحف الوصول إلى موقع الويب بالكامل بشكل افتراضي. يقوم ملف robots.txt بتحسين هذه الأذونات.

لماذا تحتاج إلى ملف Robots.txt

يوفر استخدام ملف robots.txt العديد من المزايا:

- التحكم في الزحف: يسمح لك بإدارة الأجزاء التي يتم الزحف إليها من موقعك بواسطة محركات البحث، مما يقلل من الحمل على خادمك ويمنع فهرسة المحتوى الحساس.

- تحسين تحسين محركات البحث: يمكنك تركيز برامج زحف محركات البحث على الصفحات الأكثر أهمية في موقعك الإلكتروني، مما يضمن فهرسة المحتوى المناسب لتحسين تصنيفات البحث الخاصة بك.

- حماية المحتوى الحساس: على الرغم من أن ملف robots.txt لا يمكنه منع الوصول إلى البيانات الحساسة، إلا أنه يمكن أن يساعد في إخفاء الصفحات الخاصة عن برامج زحف محركات البحث، مثل صفحات تسجيل الدخول أو أقسام المشرف.

كيفية إنشاء ملف Robots.txt

إن إنشاء ملف robots.txt سهل، ويمكنك القيام بذلك باستخدام أي محرر نص عادي مثل المفكرة, تحرير النص, viأو إيماكس. تجنب استخدام معالجات النصوص مثل Microsoft Word، لأنها يمكن أن تقدم تنسيقات قد تتداخل مع الأداء السليم للملف.

1. إنشاء الملف

افتح محرر النصوص واحفظ ملفاً باسم الروبوتات.txt. تأكد من ترميزه في UTF-8 الشكل.

2. إضافة قواعد

ابدأ بإضافة القواعد عن طريق تحديد وكلاء المستخدمين الذين تنطبق عليهم القواعد وأجزاء موقعك المسموح لهم (أو غير المسموح لهم) بالزحف إليها.

فيما يلي مثال على كيفية حظر جميع برامج زحف الويب من الوصول إلى دليل معين:

وكيل المستخدم: *

عدم السماح: /الدليل الخاص/3. تحميل الملف

قم بتحميل الروبوتات.txt إلى الدليل الجذر لموقعك على الويب الخاص بك. على سبيل المثال، إذا كان موقعك www.example.com، يجب أن يكون الملف في www.example.com/robots.txt. إذا لم تكن متأكدًا من كيفية الوصول إلى الدليل الجذر، فاتصل بمزود خدمة الاستضافة الخاص بك.

4. اختبار الملف

بعد تحميل الملف، يمكنك اختباره عن طريق فتح متصفح في الوضع الخاص والانتقال إلى https://www.example.com/robots.txt. إذا كان بإمكانك عرض الملف، فهذا يعني أنه تم تحميل الملف بنجاح.

قواعد الروبوتات.txt الشائعة

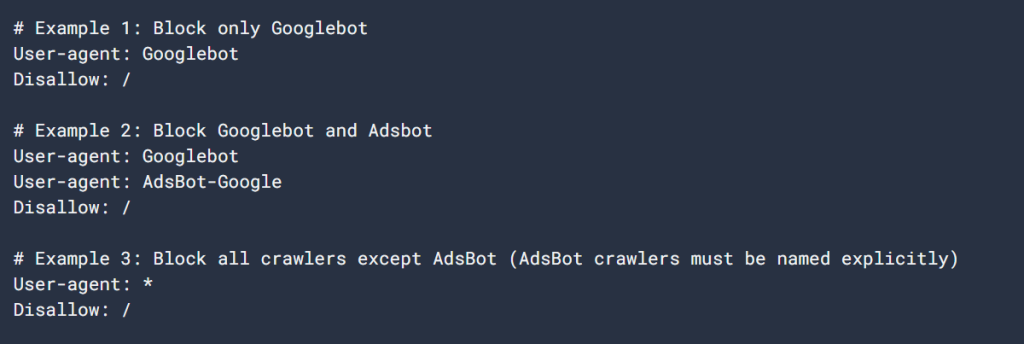

فيما يلي بعض القواعد الشائعة المستخدمة في ملفات robots.txt:

1. حظر جميع برامج الزحف من الموقع بأكمله

وكيل المستخدم: *

عدم السماح: /تمنع هذه القاعدة جميع برامج الزحف من الوصول إلى الموقع الإلكتروني بأكمله. كن حذرًا مع هذه القاعدة، لأنها تمنع محركات البحث من فهرسة المحتوى الخاص بك.

2. السماح لجميع برامج الزحف بالوصول إلى الموقع بأكمله

وكيل المستخدم: *

السماح: /تسمح هذه القاعدة لجميع برامج زحف الويب بالوصول إلى موقعك الإلكتروني بالكامل. إنه السلوك الافتراضي إذا لم تحدد أي قواعد في ملف robots.txt الخاص بك.

3. حظر دليل محدد

وكيل المستخدم: *

عدم السماح: /الدليل الخاص/تمنع هذه القاعدة جميع برامج الزحف من الوصول إلى /دليل خاص/دليل خاص/. تذكر أن الشرطة المائلة اللاحقة تشير إلى أن كل شيء داخل الدليل غير مسموح به أيضًا.

4. السماح بدليل محدد، وحظر البقية

وكيل المستخدم: *

عدم السماح: /

السماح: /عامة/تحظر هذه القاعدة الوصول إلى الموقع بأكمله باستثناء /عامة/ الدليل. يكون هذا مفيدًا عندما تريد الحفاظ على خصوصية معظم موقعك ولكنك تسمح بفهرسة صفحات عامة محددة.

5. حظر صفحة معينة

وكيل المستخدم: *

عدم السماح: /useless_page.htmlتمنع هذه القاعدة جميع برامج الزحف من الوصول إلى صفحة معينة على موقعك.

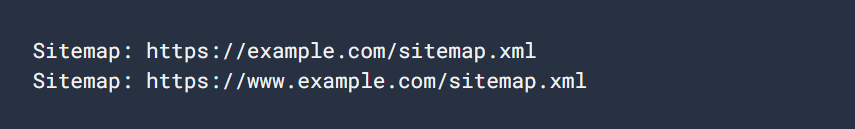

6. تحديد خريطة الموقع

خريطة الموقع: https://www.example.com/sitemap.xmlيساعد تضمين خريطة موقع في ملف robots.txt الخاص بك محركات البحث في تحديد موقع جميع الصفحات الأساسية على موقعك والزحف إليها بسرعة.

أفضل الممارسات لملفات Robots.txt

عند إنشاء ملف robots.txt، ضع في اعتبارك أفضل الممارسات التالية:

- كن محدداً: احظر فقط الصفحات أو الدلائل التي لا تريد أن تزحف إليها محركات البحث.

- استخدام الحالة المناسبة: القواعد حساسة لحالة الأحرف، لذا عدم السماح: /خاص/خاص/ و عدم السماح: /خاص/خاص/ سيحظر الدلائل المختلفة.

- لا تستخدم Robots.txt للبيانات الحساسة: ملف robots.txt عام ويمكن لأي شخص الوصول إليه. إذا كان لديك محتوى حساس، مثل صفحات تسجيل الدخول أو مناطق الإدارة، استخدم طرق مصادقة مناسبة لحمايتها بدلاً من الاعتماد على robots.txt.

- التحديث بانتظام: تأكد من تحديث ملف robots.txt الخاص بك مع التغييرات التي تطرأ على بنية موقعك الإلكتروني.

كيفية اختبار وإرسال ملف Robots.txt الخاص بك

بعد تحميل ملف robots.txt الخاص بك، يمكنك اختبار صلاحيته باستخدام أداة اختبار robots.txt في Google Search Console. تساعد هذه الأداة في التأكد من أن ملفك منسق بشكل مناسب وأن Google يمكنه تفسيره بشكل صحيح.

لإرسال ملف robots.txt إلى Google:

- انتقل إلى Google Search Console.

- استخدم اختبار روبوتات.txt للتحقق من صحة ملفك.

- بمجرد التحقق من صحته، سيجد Google تلقائيًا ملف robots.txt الخاص بك ويستخدمه.

الخاتمة

يعد ملف robots.txt جيد التنظيم أداة قوية لإدارة كيفية تفاعل محركات البحث مع موقعك. من خلال فهم كيفية إنشاء الملف وتكوينه، يمكنك التأكد من تحسين موقعك للزحف مع إخفاء المحتوى الحساس أو غير الضروري عن برامج زحف محركات البحث.

سواء كنت تدير مدونة شخصية أو موقعًا إلكترونيًا كبيرًا للشركة، يمكن لملف robots.txt الذي يتم تنفيذه بشكل صحيح أن يحسّن من تحسين محركات البحث، ويحمي المحتوى الحساس، ويضمن تشغيل موقعك بسلاسة. قم بمراجعة الملف وتحديثه بانتظام ليتماشى مع نمو موقعك والتغييرات التي تطرأ عليه.

الردود