كيفية تحسين ملف Robots.txt الخاص بك لتحسين تحسين محركات البحث على ووردبريس

أحد عناصر تحسين محركات البحث الرئيسية التي غالبًا ما يتجاهلها المبتدئون هو ملف robots.txt. يلعب هذا الملف الذي يبدو بسيطًا دورًا حيويًا في توجيه محركات البحث بشأن أجزاء موقعك على الويب التي يجب الوصول إليها والزحف إليها وفهرستها، مما يساعدك على توفير موارد الزحف القيمة وتحسين تحسين محركات البحث لموقعك على ووردبريس.

سوف يستكشف هذا الدليل الشامل سبب وكيفية تحسين ملف robots.txt الخاص بك، وأفضل الممارسات التي يجب اتباعها، والأخطاء الشائعة التي يجب تجنبها، وطرق إنشائه أو تعديله في WordPress.

ما هو ملف Robots.txt، ولماذا هو مهم لتحسين محركات البحث؟

A الروبوتات.txt هو ملف نصي مخزَّن في الدليل الجذري لموقعك على الويب يخبر محركات البحث كيفية الزحف إلى مناطق معينة من موقعك. من خلال التحكم في ما يمكن لمحركات البحث الوصول إليه، فإن ملفًا مُحسَّنًا جيدًا الروبوتات.txt يمكن للملف:

- ساعد محركات البحث على التركيز على صفحاتك الأكثر أهمية، مما يعزز أداء تحسين محركات البحث.

- منع محركات البحث من إهدار الموارد على صفحات غير ضرورية أو منخفضة القيمة.

- تحكم في المحتوى الذي يظهر في نتائج البحث، مما يساعدك على إدارة الصورة العامة لموقعك.

بدون الروبوتات.txt ملف، ستظل محركات البحث تزحف إلى موقعك، ولكن ستفقد القدرة على توجيهها بعيدًا عن الصفحات التي لا تساهم في تحقيق أهداف تحسين محركات البحث.

العناصر المهمة في ملف Robots.txt

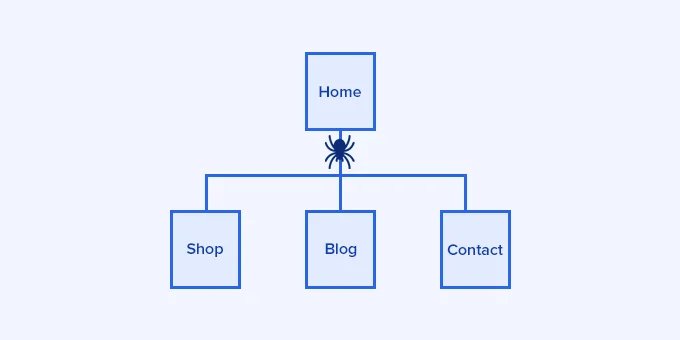

يتضمن ملف robots.txt تعليمات لروبوتات محرك البحث، أو "وكلاء المستخدم"، تحدد أجزاء موقعك التي يجب الزحف إليها أو تجاهلها. فيما يلي تفصيل بسيط للمكونات:

- وكيل المستخدم: يحدّد روبوت محرك البحث الذي تنطبق عليه القاعدة (على سبيل المثال، Googlebot لروبوت جوجل).

- عدم السماح: منع الروبوتات من الوصول إلى عناوين URL أو أدلة محددة.

- السماح: يسمح للروبوتات بالزحف إلى عناوين URL محددة، مما يساعد على تجاوز قواعد عدم السماح.

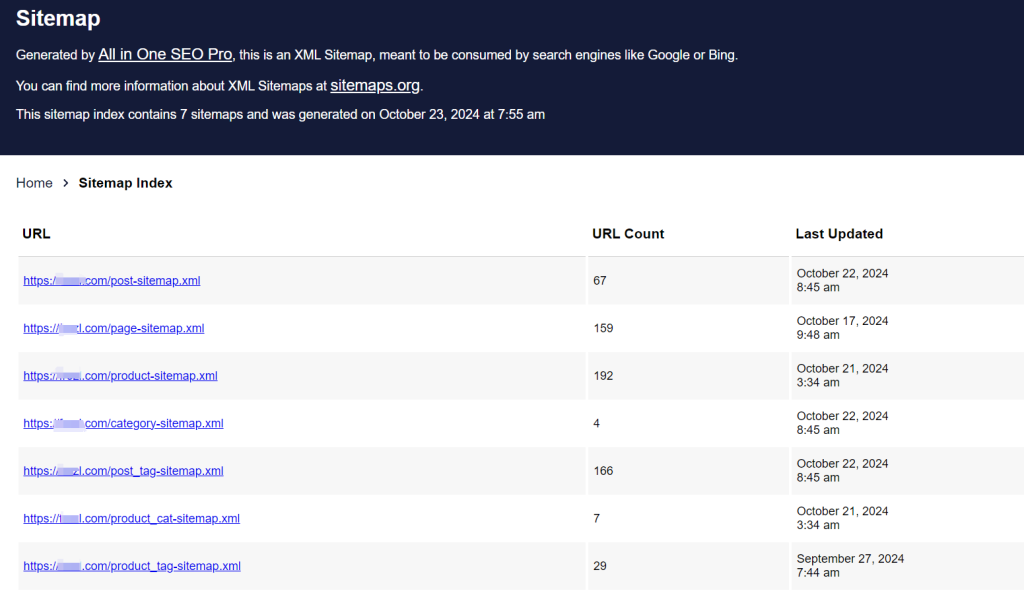

- خريطة الموقع: يشير إلى موقع خريطة الموقع XML الخاصة بك، والتي توفر لمحركات البحث قائمة كاملة بعناوين URL على موقعك لتسهيل اكتشافها وفهرستها.

نموذج بنية ملف Robots.txt

إليك الهيكل الأساسي لـ الروبوتات.txt file:

وكيل المستخدم: [اسم وكيل المستخدم]

عدم السماح: [سلسلة URL لا يتم الزحف إليها]

وكيل المستخدم: [اسم وكيل المستخدم]

السماح: [سلسلة URL المراد الزحف إليها]

خريطة الموقع: [عنوان URL لخريطة موقع XML الخاصة بك]

على سبيل المثال، في إعداد موقع ووردبريس، فإن الروبوتات.txt قد يبدو الملف هكذا

وكيل المستخدم: *

السماح: /wp-content/uploads/

عدم السماح: /wp-content/plugins/

عدم السماح: /wp-admin/

خريطة الموقع: https://example.com/sitemap_index.xmlهذا المثال يسمح للروبوتات بالوصول إلى ملفات الوسائط في /تحميل/ الدليل، يقيد الوصول إلى /الإضافات/ و /إدمن/ الدلائل، وتتضمن عنوان URL لخريطة الموقع لتسهيل عثور الروبوتات على عناوين URL لموقعك.

لماذا تحتاج إلى ملف Robots.txt لموقع ووردبريس الخاص بك؟

ملف robots.txt غير مطلوب لمحركات البحث للزحف إلى موقعك. ومع ذلك، باستخدام واحد، يمكنك تجربة فرصة توجيه الروبوتات بشكل أكثر فعالية. بالنسبة للمواقع الأكثر أهمية أو المواقع ذات الهياكل المعقدة، يعد ملف robots.txt ضروريًا لحفظ موارد الزحف، وإعطاء الأولوية للصفحات عالية القيمة، وضمان عدم وصول محركات البحث إلى المحتوى غير الضروري.

أهمية ميزانية الزحف

تخصص محركات البحث حصة محددة للزحف لكل موقع إلكتروني، وغالبًا ما تسمى "ميزانية الزحف". ستزحف الروبوتات إلى عدد محدود من الصفحات في كل زيارة، وإذا استنفدت هذه الحصة على صفحات منخفضة القيمة أو غير ذات صلة، فقد يفوتها محتوى أساسي. يساعدك ملف robots.txt المحسّن جيدًا على حفظ موارد الزحف لصفحاتك الأكثر قيمة، مما يقلل من الوقت الذي تستغرقه محركات البحث لفهرسة المحتوى الجديد أو المحدّث.

التحكم في رؤية المحتوى

يمكن أن يساعدك ملف robots.txt في منع محركات البحث من فهرسة صفحات معينة قد لا تحتاج إلى الظهور في نتائج البحث، مثل صفحات الإدارة أو الملفات الخاصة أو المحتوى الرقيق. ومع ذلك، فإن استخدام ملف robots.txt لحظر المحتوى لا يخفيه تمامًا عن الجمهور؛ فهو ببساطة يمنع محركات البحث من فهرسته.

بنية ملف Robots.txt المثالية لوردبريس

معيار الروبوتات.txt لمواقع ووردبريس عادةً قواعد للتحكم في الوصول إلى المناطق الحساسة وتقليل الزحف غير الضروري. فيما يلي مثال يعمل بشكل جيد لمعظم مواقع ووردبريس:

وكيل المستخدم-المستخدم: *

السماح: /wp-content/uploads/

عدم السماح: /wp-admin/

عدم السماح: /readme.html

عدم السماح: /REFER/

خريطة الموقع: https://www.example.com/post-sitemap.xml

خريطة الموقع: https://www.example.com/page-sitemap.xmlالسماح /wp-content/uploads/: يمنح الوصول إلى ملفات الوسائط مثل الصور.

عدم السماح بـ /wp-admin/: يمنع الوصول إلى دليل إدارة ووردبريس.

عدم السماح بـ /readme.html: تقييد الوصول إلى ملف readme الخاص بـ WordPress، والذي قد يحتوي على معلومات إصدار حساسة.

عدم السماح ب /إحالة/منع فهرسة الروابط التابعة المخفية أو عناوين URL الأخرى التي قد ترغب في إخفائها.

طرق إنشاء ملف Robots.txt وتحريره في ووردبريس

هناك عدة طرق لإنشاء ملف robots.txt وإدارته على ووردبريس، مما يسمح لك باختيار الطريقة التي تناسب خبرتك التقنية. فيما يلي ثلاث طرق شائعة:

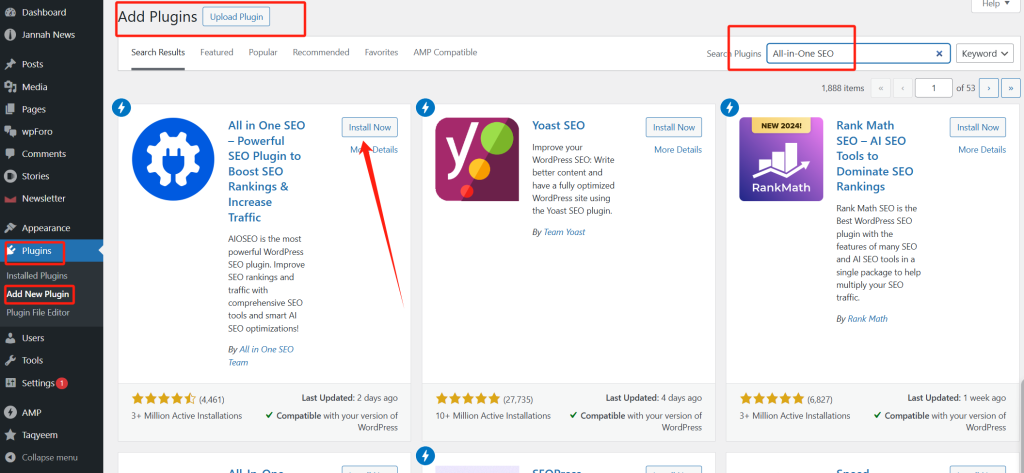

الطريقة 1: استخدام ملحق تحسين محركات البحث الكل في واحد (AIOSEO)

مُحسِّن محركات البحث الكل في واحد (AIOSEO) هو إضافة شهيرة لتحسين محركات البحث مع محرر روبوتات.txt مدمج، وهو مثالي للمبتدئين.

1. تثبيت AIOSEO.

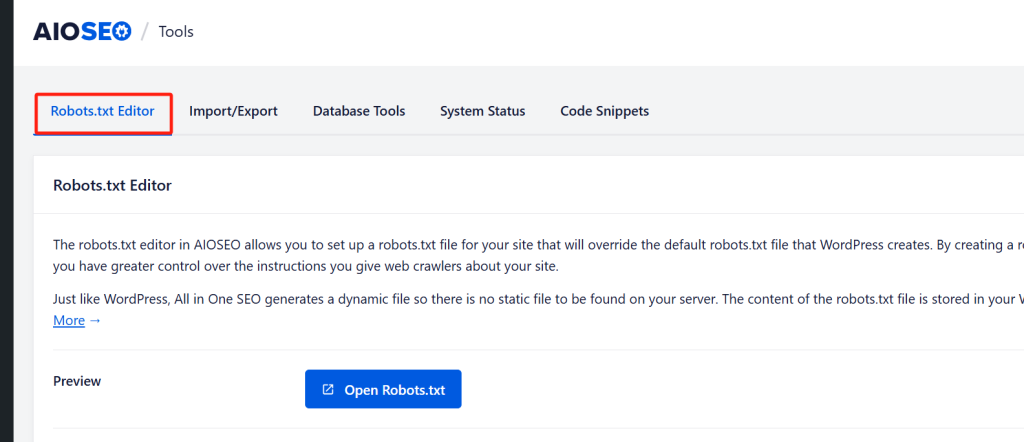

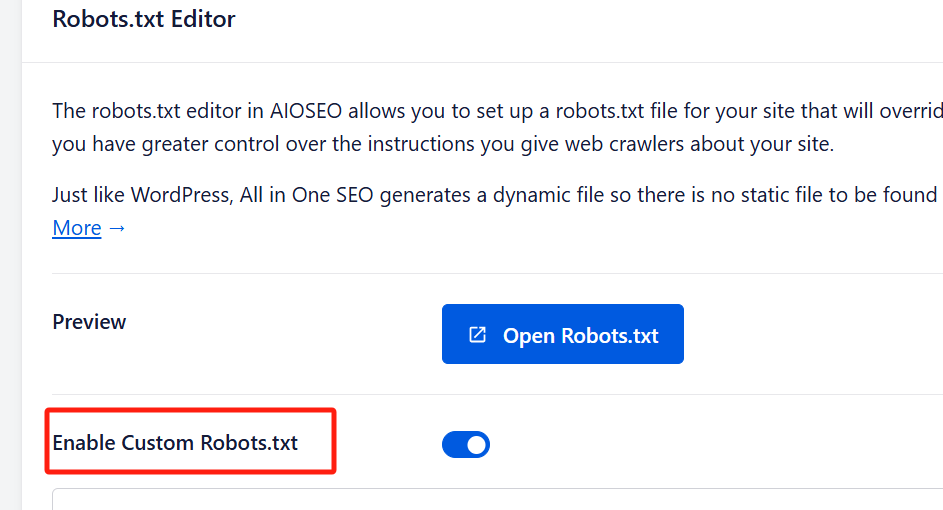

2. تمكين Robots.txt مخصص: انتقل إلى الكل في واحد لتحسين محركات البحث " أدوات بمجرد التثبيت. قم بتبديل "تمكين الروبوتات المخصصة" لتشغيل التحرير.

3. التحرير والتخصيص: في المحرر، قم بإضافة قواعد من خلال تحديد وكيل المستخدم، واختيار "السماح" أو "عدم السماح"، وإدخال مسارات الدليل.

4. المعاينة والحفظ: تحقق من المعاينة للتأكد من دقة التغييرات التي أجريتها ثم انقر فوق "حفظ التغييرات".

محرر AIOSEO سهل الاستخدام ويتضمن ميزة المعاينة، مما يتيح لك رؤية قواعدك قبل الحفظ.

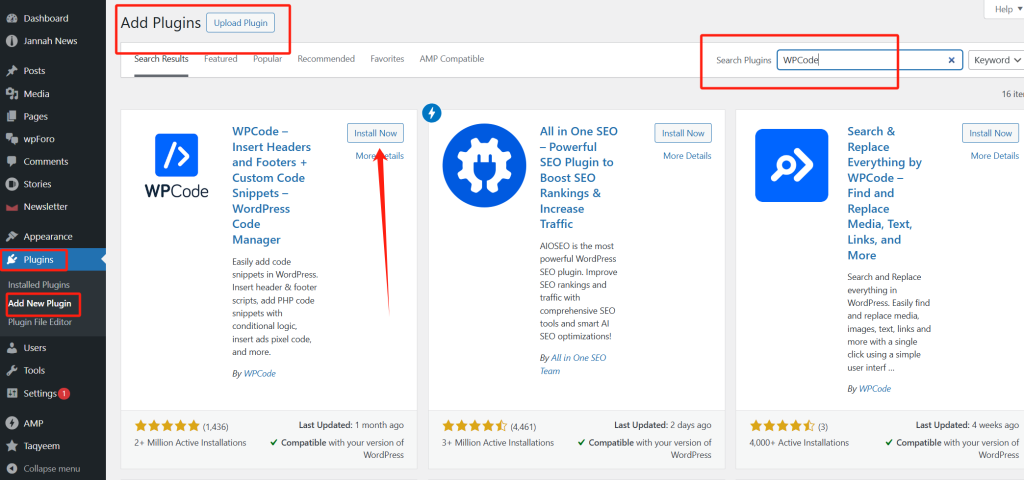

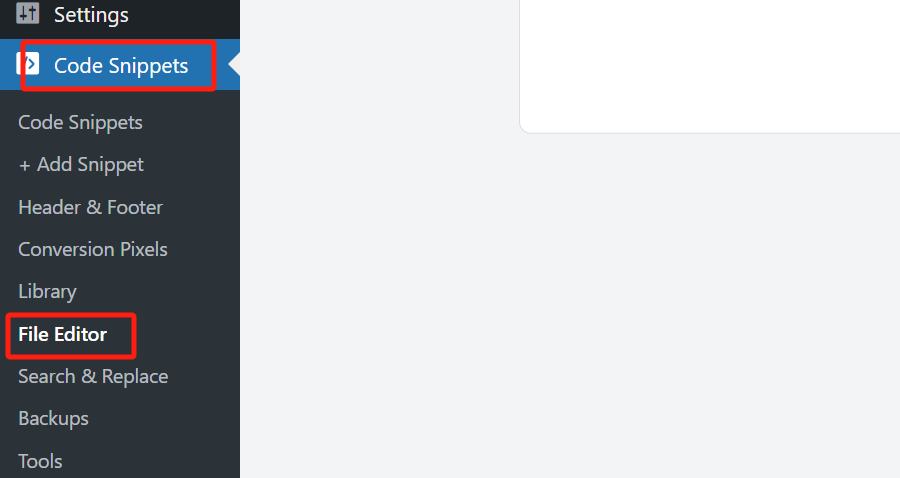

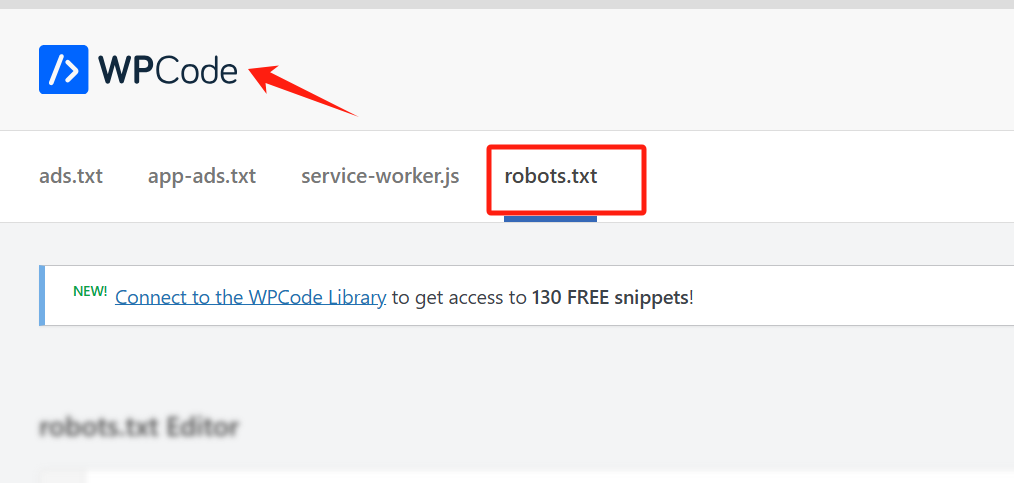

الطريقة 2: استخدام WPCode

WPCode هو إضافة ووردبريس أخرى تتضمن محرر robots.txt، مما يتيح سهولة الوصول إلى إدارة الملفات دون الحاجة إلى FTP.

1. تثبيت WPCode.

2. فتح محرر الملفات: انتقل إلى رمز WPCOD " محرر الملفات وحدد علامة التبويب robots.txt.

3. أضف قواعدك: أدخل قواعد robots.txt حسب الحاجة.

4. الحفظ: انقر فوق "حفظ التغييرات" لتطبيق الإعدادات الخاصة بك.

ملاحظة: لا تتضمن نسخة WPCode المجانية من WPCode الروبوتات.txt خاصية المحرر، لذا ستحتاج إلى الإصدار المدفوع.

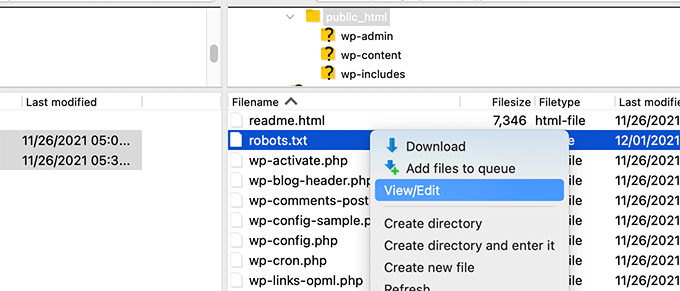

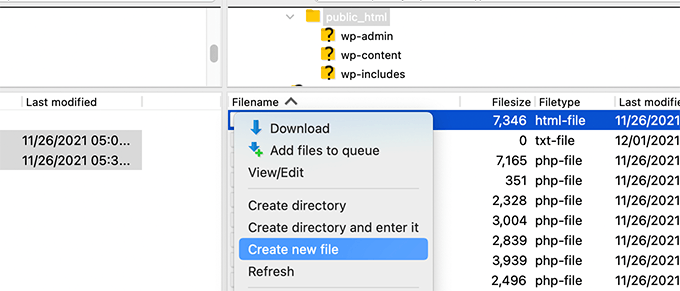

الطريقة 3: تحرير Robots.txt يدويًا عبر FTP

يمكن للمستخدمين المتقدمين أو المطلعين على FTP إنشاء ملف robots.txt وتحميله يدويًا.

1. الوصول إلى موقعك عبر FTP: الوصول إلى ملفات ووردبريس الخاصة بك باستخدام عميل FTP (على سبيل المثال، FileZilla).

2. تحديد موقع أو إنشاء Robots.txt: ابحث عن الملف في الدليل الجذر أو أنشئ ملفًا جديدًا إذا لم يكن موجودًا.

3. تحرير الملف: قم بتنزيله وتحريره في محرر نص عادي وحفظه.

4. تحميل الملف المحدّث: أعد تحميل الملف إلى الدليل الجذر لموقعك.

توفر هذه الطريقة أكبر قدر من التحكم ولكنها تتطلب الإلمام ببروتوكول نقل الملفات (FTP) وهياكل الدليل.

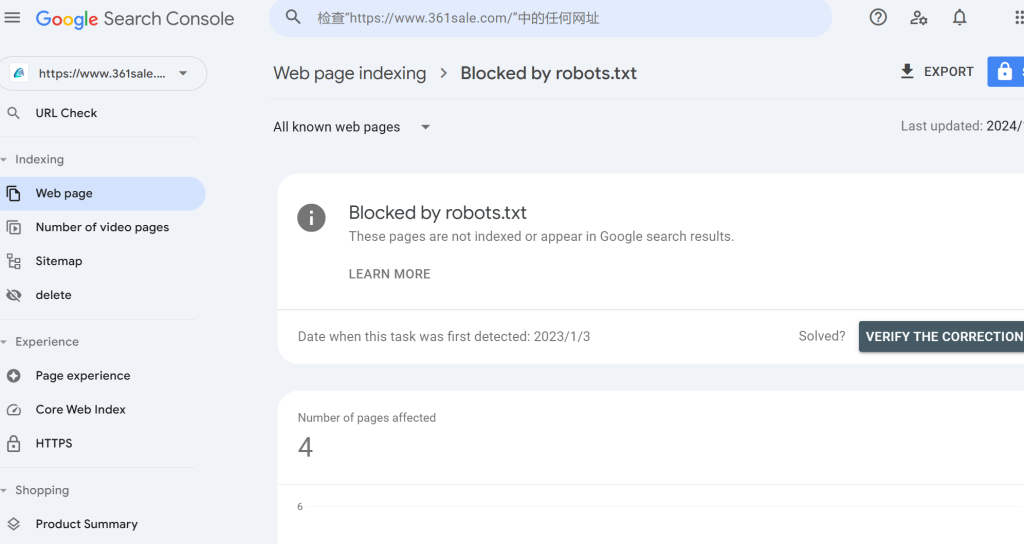

اختبار ملف Robots.txt الخاص بك بحثًا عن أخطاء

بمجرد نشر ملف robots.txt الخاص بك، من المهم اختباره للتأكد من أن محركات البحث تفسره بشكل صحيح. توفر Google Search Console أداة اختبار robots.txt مدمجة لمساعدتك في التحقق من وجود أخطاء.

1. ربط موقعك بوحدة تحكم بحث Google: إذا لم تكن قد فعلت ذلك بالفعل، فأضف موقعك إلى Google Search Console.

2. الوصول إلى أداة اختبار الروبوتات: افتح أداة اختبار الروبوتات في Google Search Console.

3. التحقق من وجود أخطاء: ستقوم الأداة بجلب ملف robots.txt الخاص بك وعرض أي مشاكل في بناء الجملة أو التحذيرات.

الأخطاء الشائعة التي يجب تجنبها في تحسين Robots.txt

لتعظيم إمكانات تحسين محركات البحث الخاصة بك الروبوتات.txt ملف، تجنب هذه المزالق الشائعة:

- حظر المحتوى الأساسي: تجنب حظر الصفحات أو الموارد الهامة مثل ملفات CSS وجافا سكريبت. ينصح جوجل بالسماح للروبوتات بالوصول إلى هذه الموارد لأنها تساعد محركات البحث على فهم تخطيط الموقع ووظائفه.

- حظر صفحات الأرشيف والعلامات والفئات: يعتقد العديد من خبراء تحسين محركات البحث أن حظر صفحات الأرشيف يحسن كفاءة الزحف، لكن إرشادات مشرفي المواقع من جوجل تشير إلى خلاف ذلك. غالبًا ما تضيف هذه الصفحات قيمة إلى بنية الموقع وتجربة المستخدم.

- عدم إضافة خرائط المواقع: تضمين خرائط مواقع XML في

الروبوتات.txtيمكن أن يساعد الملف محركات البحث بشكل كبير في تحديد موقع كل المحتوى ذي الصلة على موقعك.

أفكار نهائية حول تحسين Robots.txt لتحسين محركات البحث

قد يبدو تحسين ملف robots.txt الخاص بك أمرًا ثانويًا، لكن تأثيره على تحسين محركات البحث يمكن أن يكون كبيرًا. من خلال توجيه محركات البحث إلى المكان الذي يجب التركيز عليه، يمكنك التأكد من أن الروبوتات تزحف بكفاءة وتفهرس المحتوى الأكثر أهمية لديك، مما يحسن أداء تحسين محركات البحث لموقعك بشكل عام. استخدم الأمثلة والطرق وأفضل الممارسات التي تمت مناقشتها هنا لإنشاء ملف robots.txt مُحسَّن والتحكم في كيفية تفاعل محركات البحث مع موقع ووردبريس الخاص بك.

الردود